Bild- und Videotechnik

Multimedia-Grundlagen und Formate (Version: 7. Dezember 2022)

1.1 Additives und Subtraktives Farbmodell

1.2 Vom RGB-Bild zum Graustufenbild

1.3 Das Helligkeits-Farbigkeits-Modell Luminanz/Chrominanz

1.4 Vektorgrafik versus Rastergrafik

1.5 Bildartefakte

2. Bildformate

2.1 JPEG, JPG (Joint Photographic Experts Group)

2.2 GIF, Animated GIF (Graphics Interchange Format)

2.3 PNG (Portable Network Graphics)

2.4 SVG (Scalable Vector Graphics)

2.5 BMP (Windows Bitmap)

2.6 TIF (Tagged Image File Format)

2.7 PSD (Photoshop-Bilddatei)

3. Transparenzmasken und Alphakanal

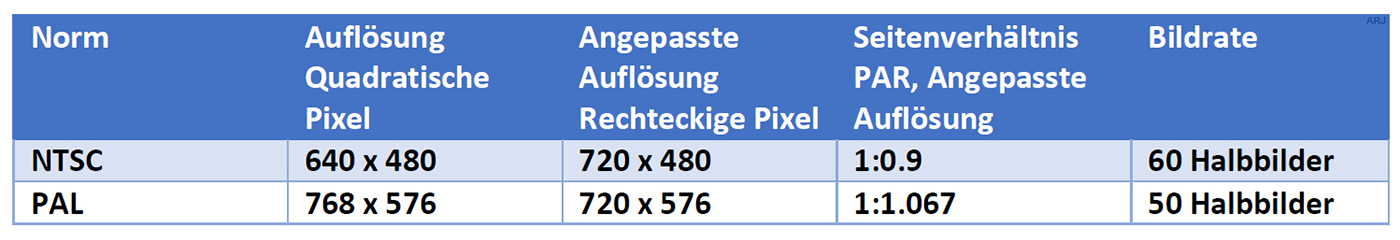

4.1 Historische Fernsehnormen in Standard-Definition

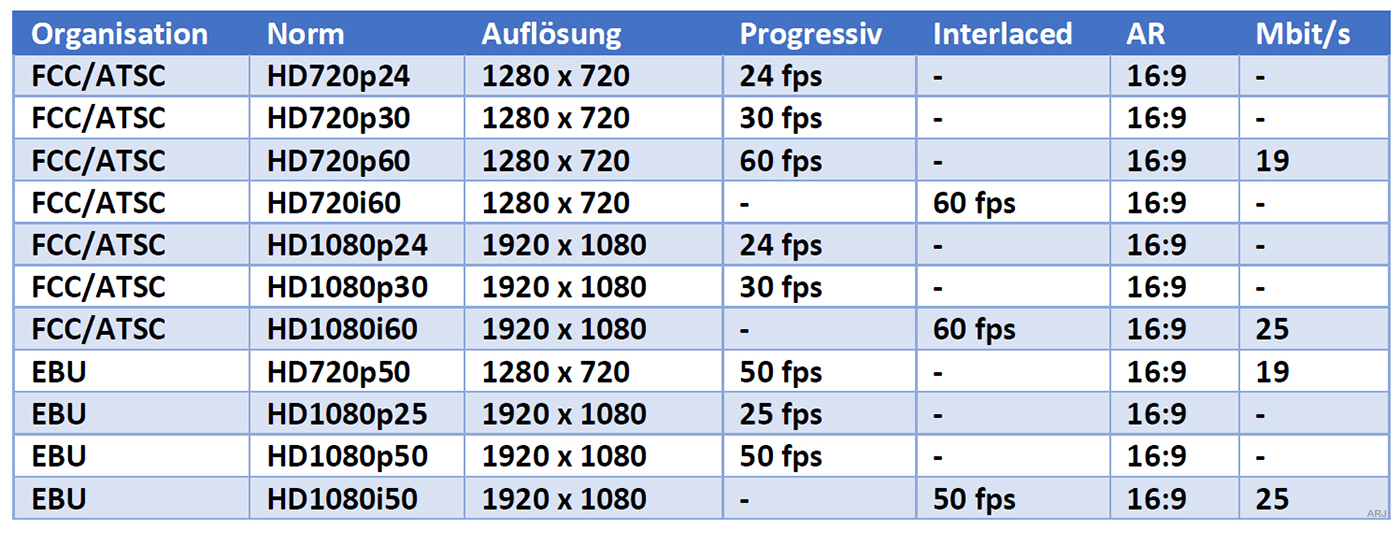

4.2 Aktuelle Fernsehnormen in High-Definition

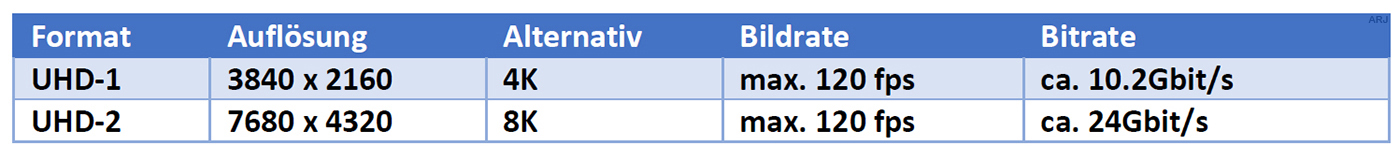

4.3 Next generation HD (UHD)

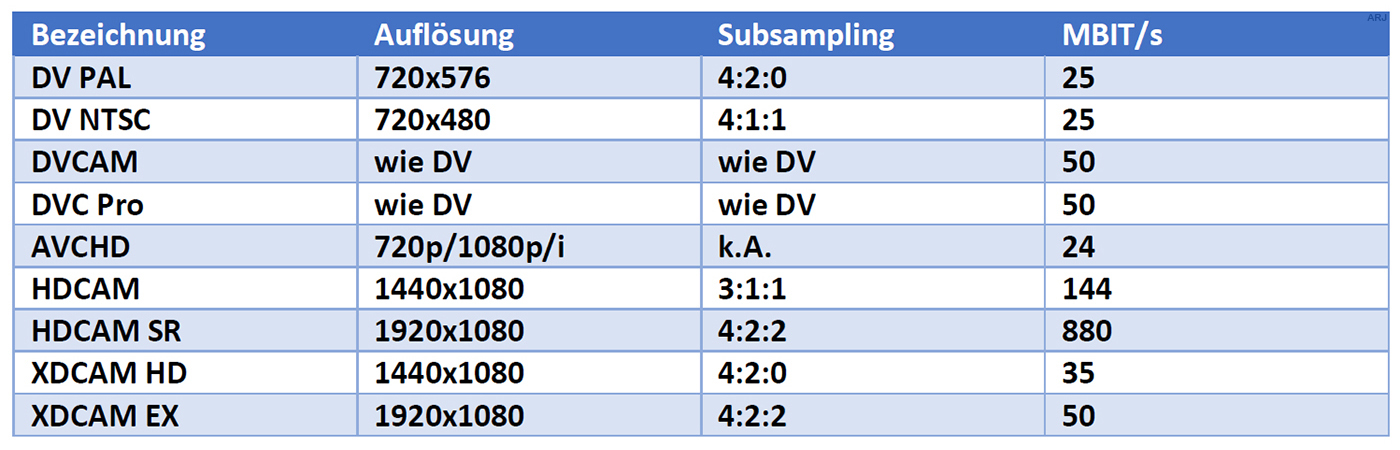

4.4 Video-Normen und Datenraten

4.5 Übertragungsraten gängiger Schnittstellen

4.6 Codecs und Containerformate

5. Datenkompression

5.1 Bildauflösung und Farbtiefe reduzieren

5.2 Die Farbunterabtastung/Subsampling

5.3 JPG-Bildkomprimierung mit DCT (Discrete Cosine Transformation)

5.4 Interframe Komprimierung

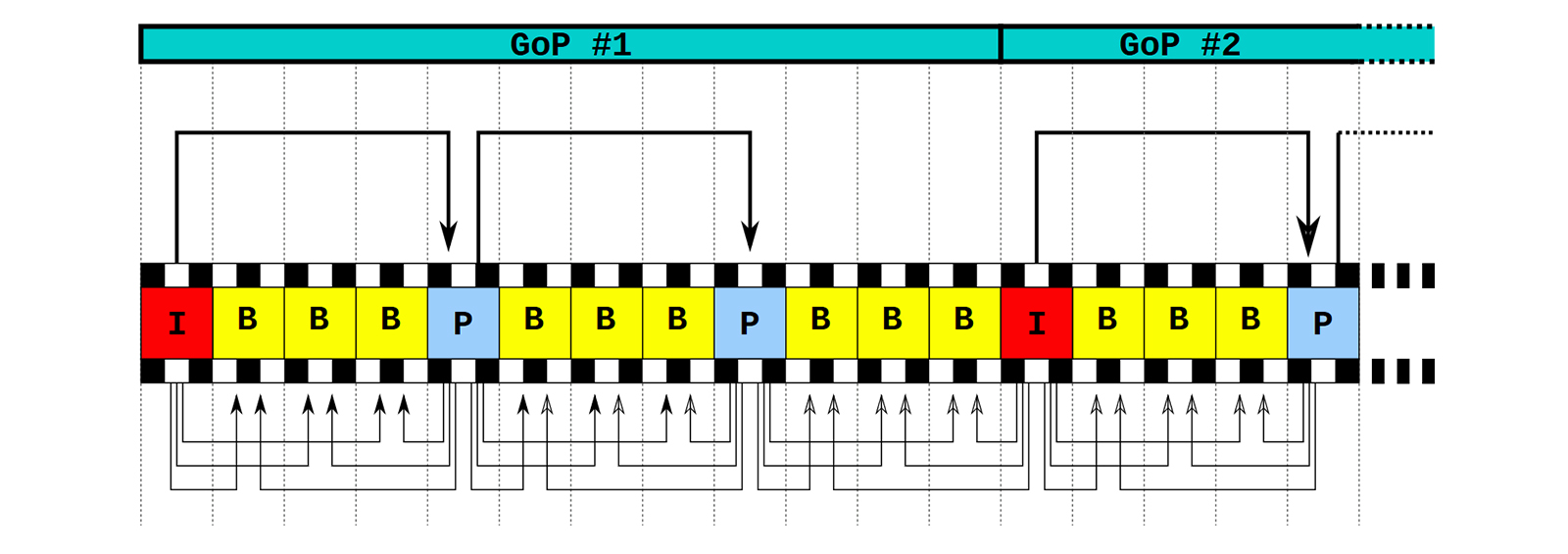

5.5 Die GOP-Sequenz

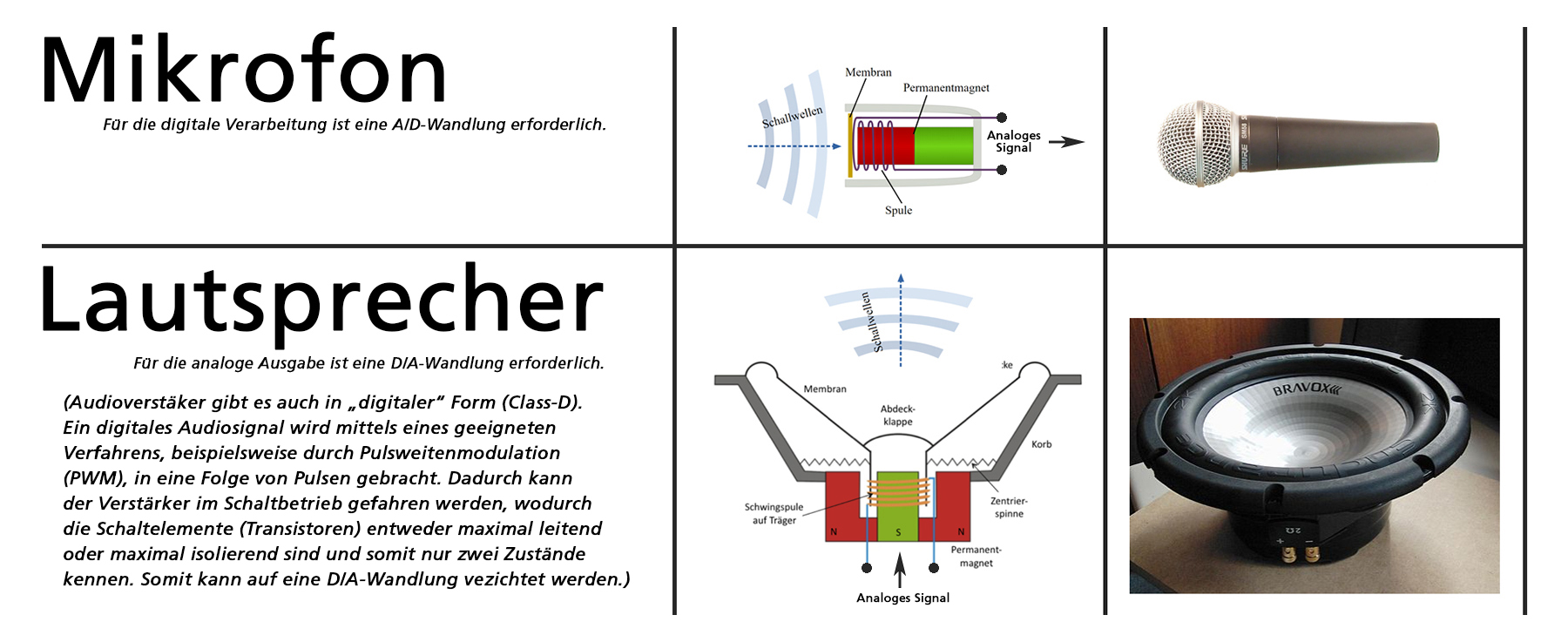

6. Audio

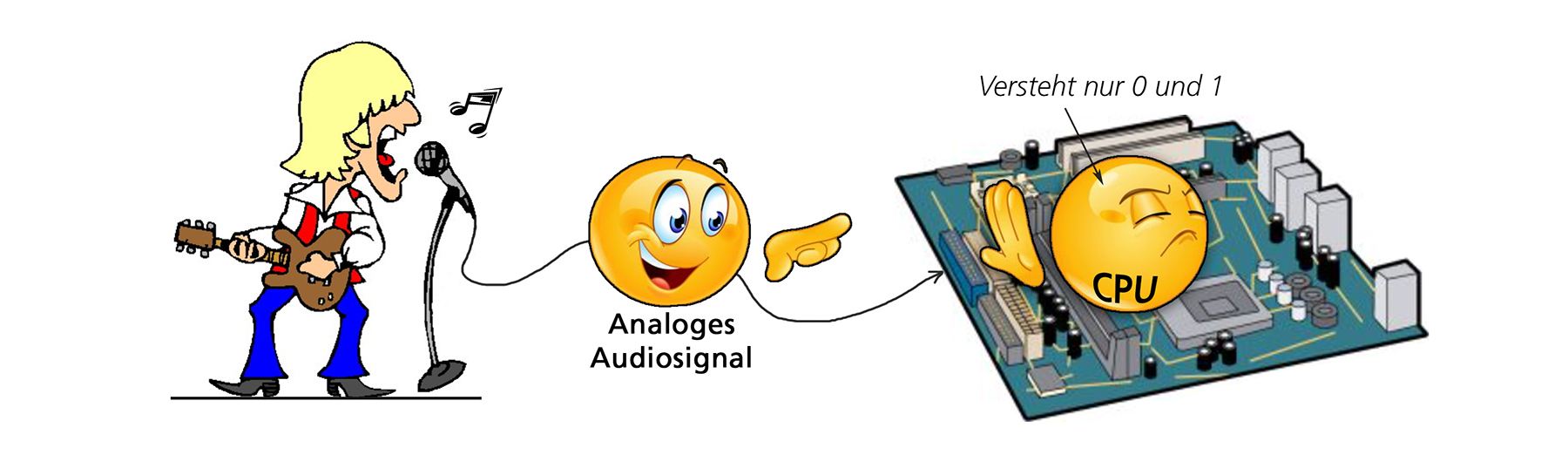

6.1 Analog-Audio

6.2 Digital-Audio

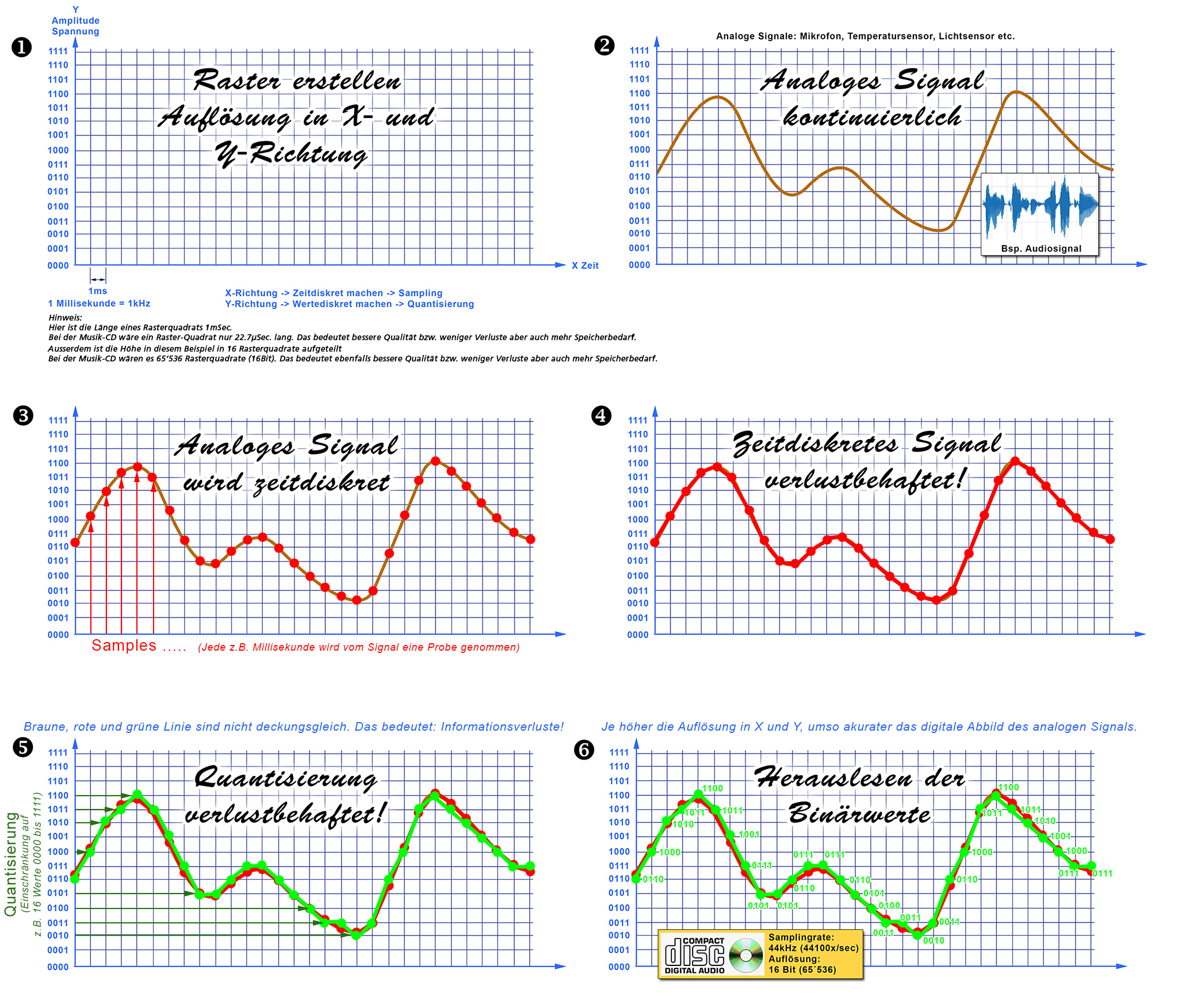

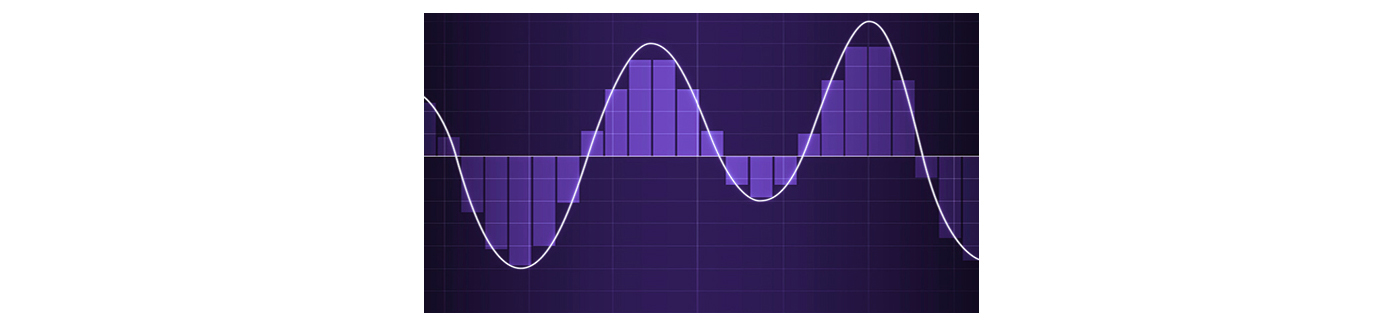

6.3 Die Analog-Digital-Wandlung

1. Einführung

Open-Source Grafik-SW

Gleich zu Begin der Hinweis auf ein paar Open-Source Grafik-Applikationen:

Für gelegentliche Grafikarbeiten lohnt es sich kaum, Applikationen des Branchen-Primus Adobe zu erwerben, die seit längerem nur noch im Abonnementsmodel angeboten werden,

und wo einzelne Applikationen kaum wesentlich günstiger sind, als die ganze, mehrteilige Creative-Suite. Und Trial-Versionen sich auch keine verfügbar.

Die kostenlose Alternative findet sich wie immer im Internet.

In einigen Übungen werden sie die folgenden Tools verwenden, um JPG, GIF, TIF und Transparenz bzw. Alphakanal etwas besser kennenzulernen:

- https://www.gimp.org (Bildbearbeitung)

- https://pixlr.com (Bildbearbeitung)

- https://inkscape.org/de (Vektorgrafik)

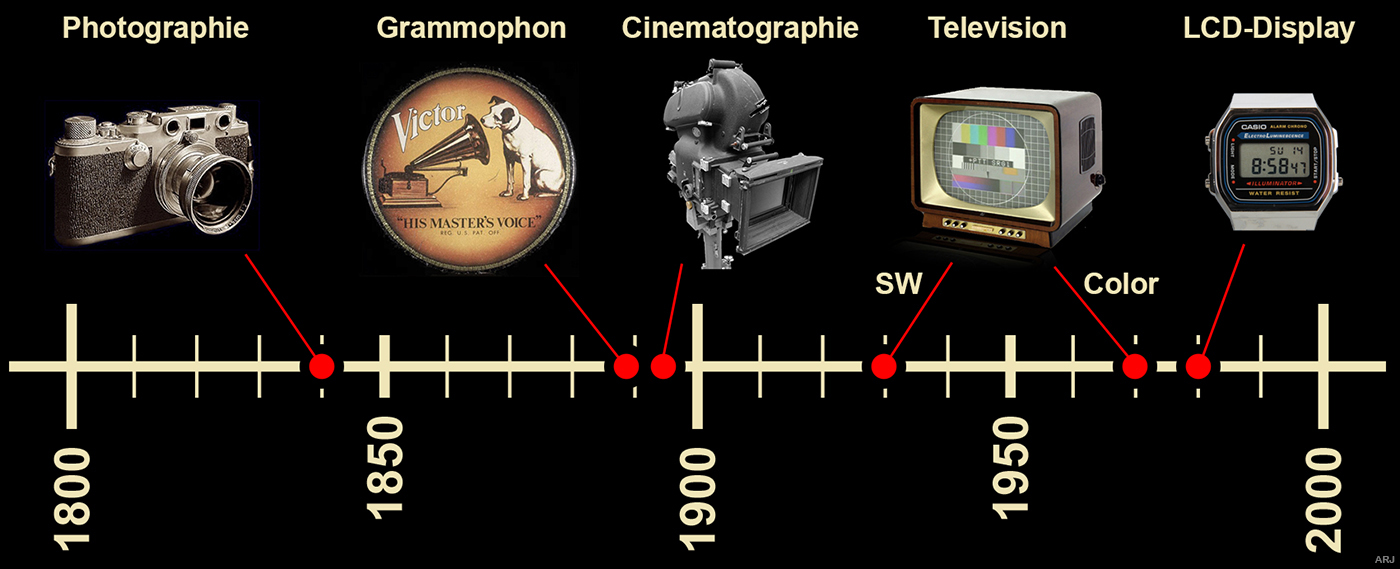

Historischer Rückblick

Wie damals alles begann:

- Von der Camera Obscura zur Digitalen Spiegelreflexkamera DSLR: Das lichtempfindliche Fotomaterial wird von lichtempfindlichen elektronischen Bildaufnahmeelementen (CCD, CMOS-Sensor) abgelöst. Wichtige Kriterien sind die Bildauflösung und die Komprimierung.

- Von Grammophon und Schallplatte zum Musikplayer im Smartphone: Das analoge Verfahren mittels Schallplatte bzw. magentischem Band wird später vom digitalen Datenträger Music-CD und zuletzt von der Datencloud abgelöst. Für die digitale Variante müssen die akustisch erzeugten Schallwellen zuerst mittels A/D-Wandlung (Samplingrate, Quantisierung) in eine vom Rechner verarbeitbare Form gebracht werden.

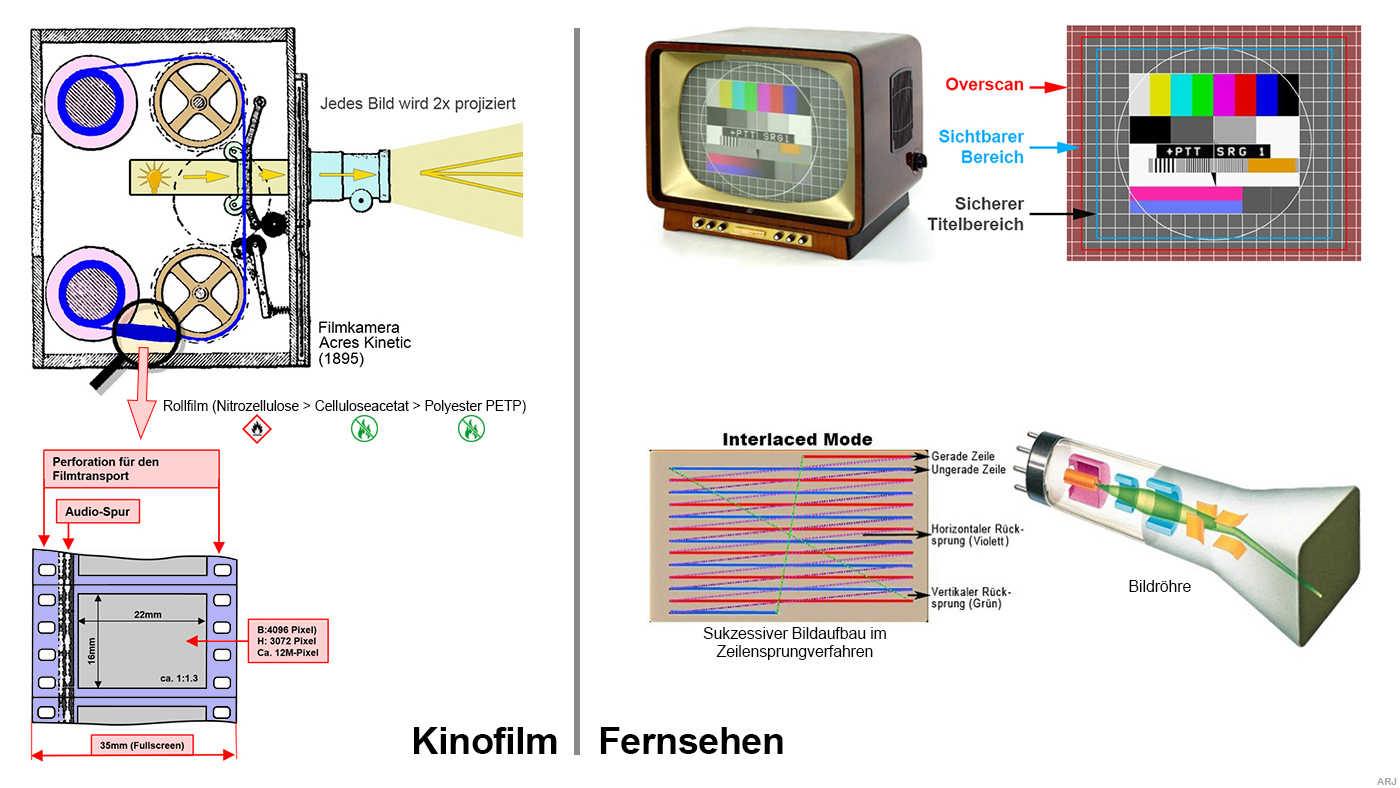

- Von der Serienfotografie zum 3D-Film: Ruckelfreie Bewegung erhält man ab ca. 12 Bilder/sec. Mehr als 50 Bildwiederholungen/sec. werden benötigt, um kein Bildflackern mehr zu erkennen. Film verwendet übrigens nur 24 Bilder/sec. Darum muss jedes Kinofilmbild zweimal an die Leinwand projiziert werden.

- Vom Röhrenbildschirm zum LCD-Flatscreen: Zur Zeit der Röhrentechnik war die geforderte Bildwiederholfrequenz von 50 Hz. nur mit einem Trick, dem Halbbildverfahren (Interlaced), realisierbar.

Vom KinoGÄNGER zum FernSEHER

Den Kinofilm gibt es seit ca. 1894. Man hat sich beim klassisches Kino weltweit auf eine Bildwiederholfrequenz von

24 Ganzbilder/sec. geeinigt. Bei den Bildformaten gibt es hingegen eine grössere Vielfalt:

Klassisch 12,5:9 / Breitbild 16:9 / Cinemascope 21:9. Auch die Digitalisierung hat beim Kinofilm Einzug gehalten.

Heutige Filme werden komplett digital produziert und in den Kinos auch digital auf Beamern vorgeführt. Aktuelle Auflösungen

bei digitalem Kinofilm: 2k = 2048Pixel/Zeile / 4k = 4096Pixel/Zeile.

Bei Breitbild- und Cinemascopeproduktionen

wird bzw. wurde das Bild anamorph aufgezeichnet. Damit konnte man ein breites Bild auf ein schmaleres Format komprimieren (verzerren)

und zur Vorführung wieder dekomprimieren (entzerren). Bei Digital-Video Standard-Definition (SD) PAL und NTSC kommt dieses Verfahren

ebenfalls zur Anwendung.

Bei Breitbild- und Cinemascopeproduktionen

wird bzw. wurde das Bild anamorph aufgezeichnet. Damit konnte man ein breites Bild auf ein schmaleres Format komprimieren (verzerren)

und zur Vorführung wieder dekomprimieren (entzerren). Bei Digital-Video Standard-Definition (SD) PAL und NTSC kommt dieses Verfahren

ebenfalls zur Anwendung.

Interlaced Mode versus Progressive Mode

Television oder auf Deutsch Fernsehen gibt es in der Schwarzweissversion seit ca. 1929 und in der Farbversion ab ca. 1967. Fernsehen wurde erst durch die Massentauglichkeit von Elektronenstrahlröhren bzw. Bildröhren möglich. Um das Bildflimmern auf ein erträgliches Mass zu reduzieren, müssen wie beim Kinofilm 50 Bilder pro Sekunde angezeigt werden. Dies war mit der damaligen Technik allerdings nicht möglich, weil die erforderlichen Bandbreiten fehlten und man mit vernünftigem Aufwand auch keine Bilder zwischenspeichern konnte. Darum bediente man sich eines Tricks: Man lieferte 50 halbe Bilder pro Sekunde und zwar einmal alle ungeraden Zeilen, gefolgt von den geraden Zeilen:

- Interlaced Mode: Es werden 50 (PAL) oder 60 (NTSC) Halbbilder pro Sekunde nacheinander (ungerade/gerade Zeile) gesendet.

Vorteil: Weniger Bandbreite erforderlich.

Nachteil: Kammeffekt bei schnell bewegten Bildern, weil diese zeilenweise nacheinander aufgezeichnet werden. - Progressive Mode: Es werden komplette Bilder nacheinander empfangen.

Vorteil: Man erhält immer ein komplettes Bild.

Nachteil: Mehr Bandbreite erforderlich.

Ein weitere Kompromiss, der man der Bildröhre schuldete, ist der Overscanbereich:

- Als Overscan wird ein Bereich an den äusseren Rändern eines Videobildes bezeichnet, dessen Sichtbarkeit nicht garantiert werden kann. Bei Projektionen, insbesondere bei Röhrenbildschirmen, werden die Bildränder durch eine Maske oder Blende abgedeckt, um Ungenauigkeiten und die (bei analogen Röhren praktisch unvermeidlichen) Geometrieabweichungen am Rand zu kaschieren und einen sauberen, geraden Bildabschluss garantieren zu können. Bei der Produktion von Filmen, Videos, DVDs und Fernsehsendungen muss dieser Overscan-Bereich von etwa 6 % berücksichtigt werden, der keine relevanten Bildelemente (z. B. Einblendungen oder Menüs) enthalten darf. Bei Bildschirmen mit aktiven Bildpunkten (z. B. LCD oder Plasma) kann das Bild pixelgenau dargestellt werden, so dass kein Overscan-Bereich nötig ist.

25 Halbbilder bzw. 50 Vollbilder pro Sekunde oder 30 Halbbilder bzw. 60 Vollbilder pro Sekunde

Als das Fernsehen erfunden wurde, setzte man weltweit auf das Seitenverhältnis 4:3. Bei der Bildwiederholungsrate allerdings unterschieden sich die Systeme:

- Angelehnt an die Netzfrequenz des öffentlichen Stromnetzes von 50 Hertz wählte man in Europa (ohne Frankreich), Australien, Teilen von Asien und Afrika eine Bildfrequenz von 25 Vollbilder bzw. 50 Halbbilder pro Sekunde. (PAL)

- Dagegen wählte man in Nord- und Südamerika bzw. Ostasien aufgrund der Netzfrequenz des öffentlichen Stromnetzes von 60 Hertz eine Bildfrequenz von 30 Vollbilder bzw. 60 Halbbilder pro Sekunde. (NTSC)

- 25fps-Original Wiedergabe mit 30fps: 1.2x schneller, d.h. 60 minütiger Film bereits in 50 Minuten abgespielt: Menschen sprechen comicartig

- 30fps-Original Wiedergabe mit 25fps: 1.2x langsamer, d.h.60 minütiger Film erst in 72 Minuten abgespielt: Männer mit Bass, Frauen mit Stimmbruch

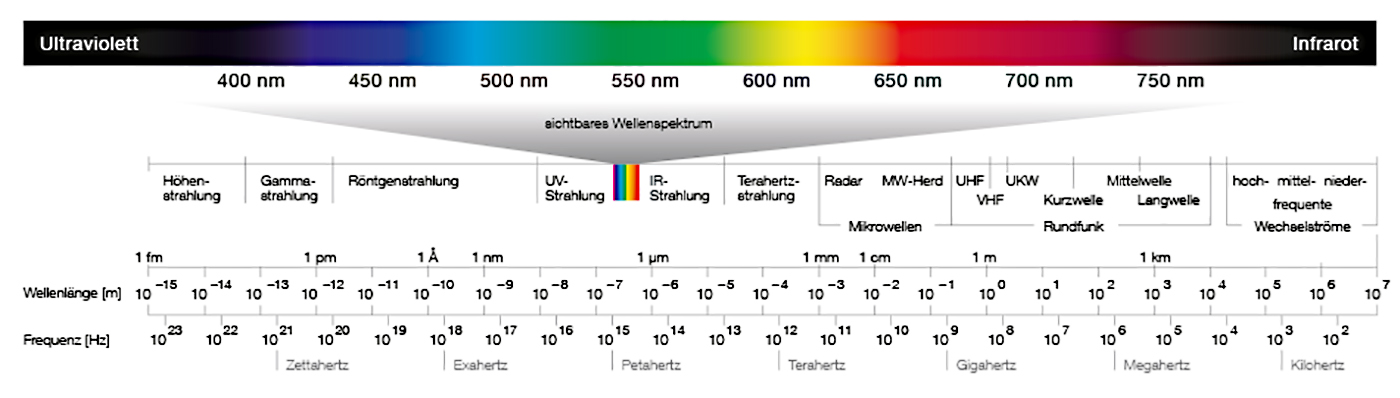

Elektromagnetische Wellen und Schallwellen

- Elektromagnetische Wellen (inklusive sichtbarem Wellenspektrum)

- Schallwellen dagegen stellen die Ausbreitung bzw. die hörbaren Schwingungen von Druck- und Dichteschwankungen in einem elastischen Medium (Gase, Flüssigkeiten, Festkörper) dar.

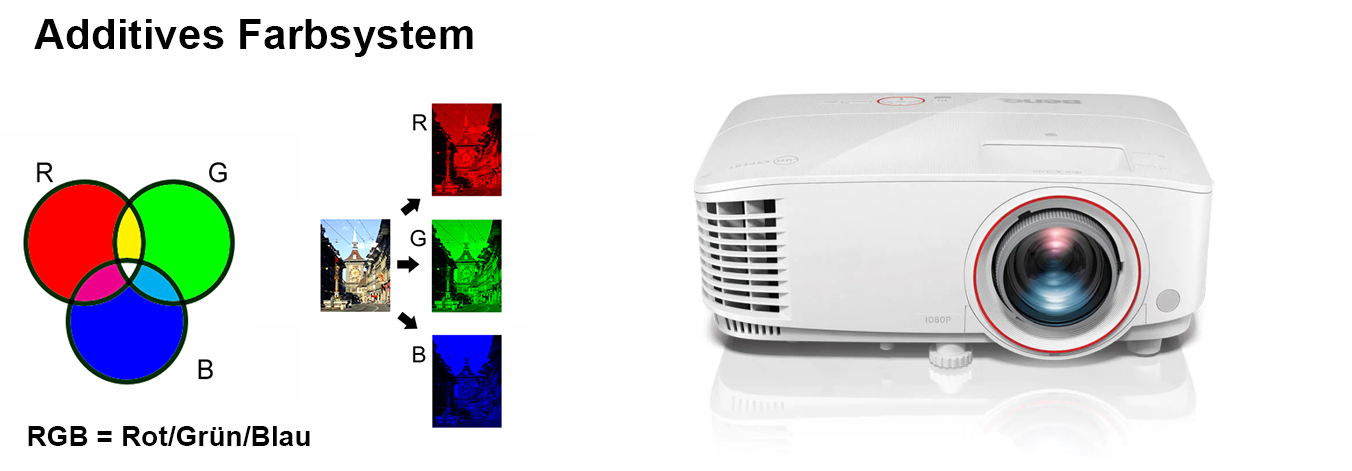

1.1 Additives und Subtraktives Farbmodell

- Additive Farbmischung: RGB = Rot/Grün/Blau. Fernseher, PC-Bildschirm, Beamer etc. Die Komplementärfarben von RGB sind CMY.

Rot/Grün/Blau zu gleichen Teilen gemischt ergibt Weiss.

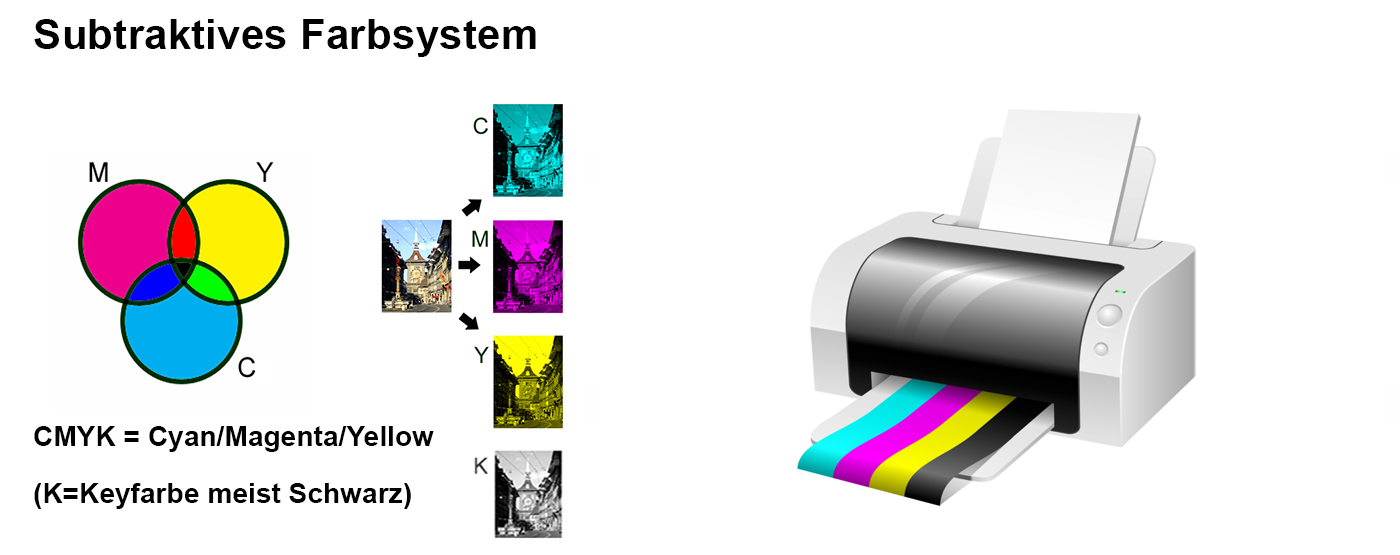

- Subtraktive Farbmischung: CMY(K) = Cyan/Magenta/Yellow/(Keycolor meist Schwarz). Drucker, Malen, Analog-Kino mit Filmstreifen etc.

Die Komplementärfarben von CMY sind RGB. Cyan/Magenta/Yellow zu gleichen Teilen gemischt ergibt Schwarz.

(Was würde passieren, wenn ich in meine Druckerpatrone statt CMYK die Grundfarben RGB einfüllen würde?

(Was würde passieren, wenn ich in meine Druckerpatrone statt CMYK die Grundfarben RGB einfüllen würde?

Im Gegensatz zum RGB Farbraum, wo die Mischfarbe additiv (Lichtfarben) entsteht, geschieht das beim CMYK Farbraum auf subtraktive Weise (Körperfarben). Das heisst, dass beim Druck im CMYK-Farbraum die Grundfarben nacheinander aufgetragen werden. Somit wird das Mischresultat mit jedem Farbauftrag dunkler. Es wäre zum Beispiel unmöglich, mit den RGB-Grundfarben einen Gelbton zu erhalten.)

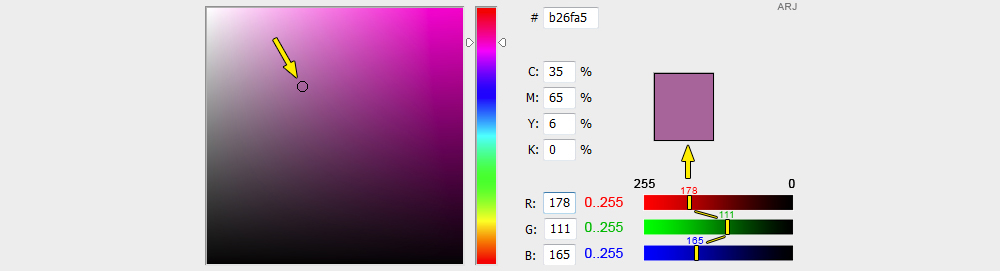

Farbwahl in Adobe Photoshop

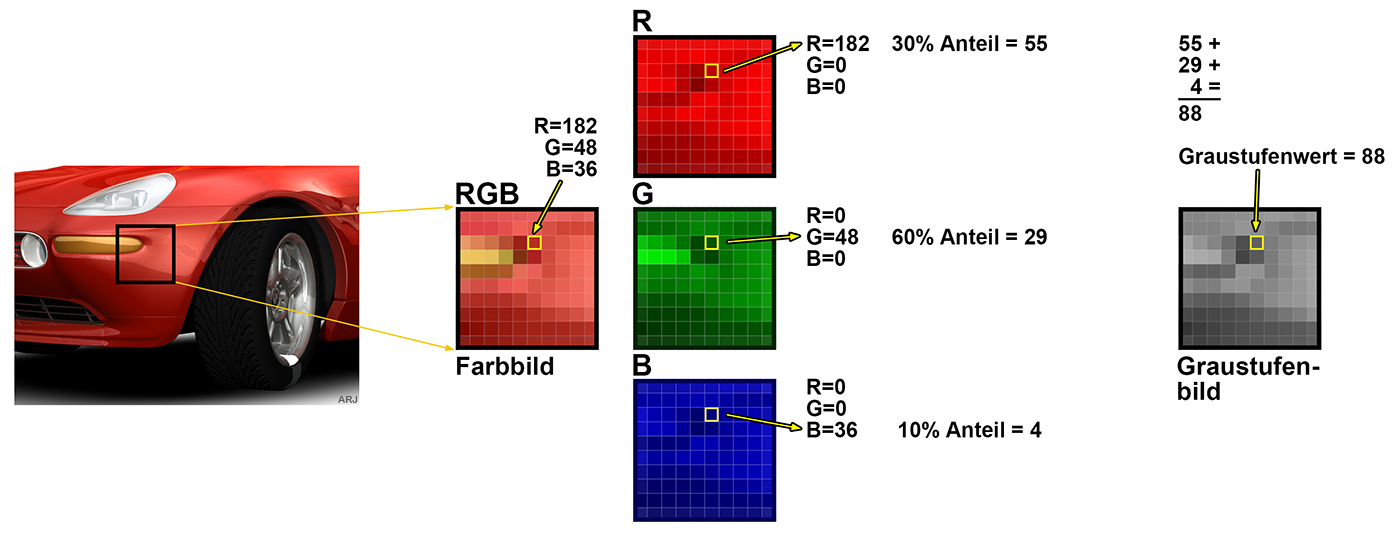

1.2 Vom RGB-Bild zum Graustufenbild

In bestimmten Fällen ist es nötig, das Farbbild in ein Graustufenbild umzuwandeln.

Zum Beispiel bei dem im nächsten Abschnitt behandelten Farbmodel YCbCr.

Bei der Umwandlung werden die drei Farbanteile RGB verschieden gewichtet. Dies hat einen historischen Hintergrund:

Der frühzeitliche Mensch als Jäger und Sammler war vor allem auf eine hohe Auflösung im Grünbereich (Wälder, Wiesen etc.) angewiesen,

um Beute oder herannahende Gefahr besser erkennen zu können. Die Farbe Blau war da eher seltener und darum weniger wichtig.

Da diese Aspekte des Farbensehens des menschlichen Auges berücksichtigt werden müssen.

So wird beispielsweise Grün heller wahrgenommen als Rot, dieses wiederum heller als Blau.

Diese unterschiedliche Gewichtung wird in folgender Umrechnungsformel berücksichtigt:

Luminanz (Y) = 0.3 x Rot + 0.6 x Grün + 0.1 x Blau

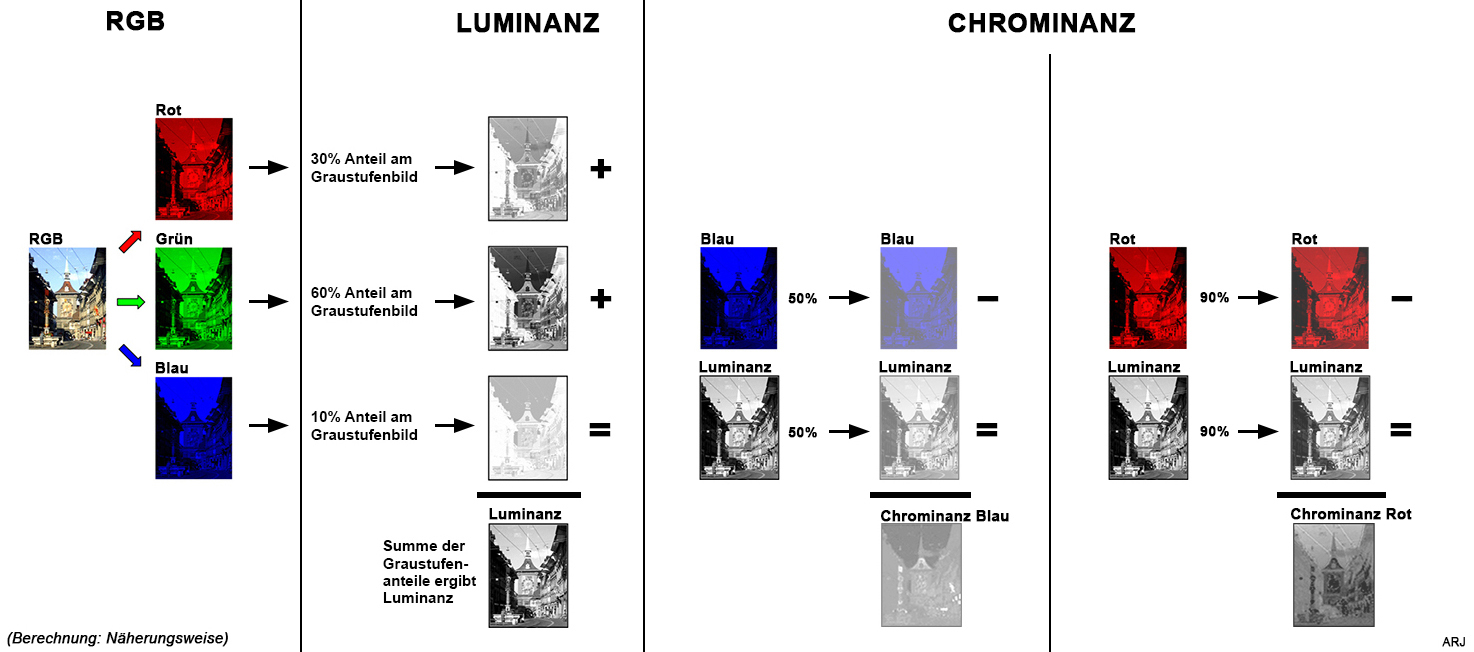

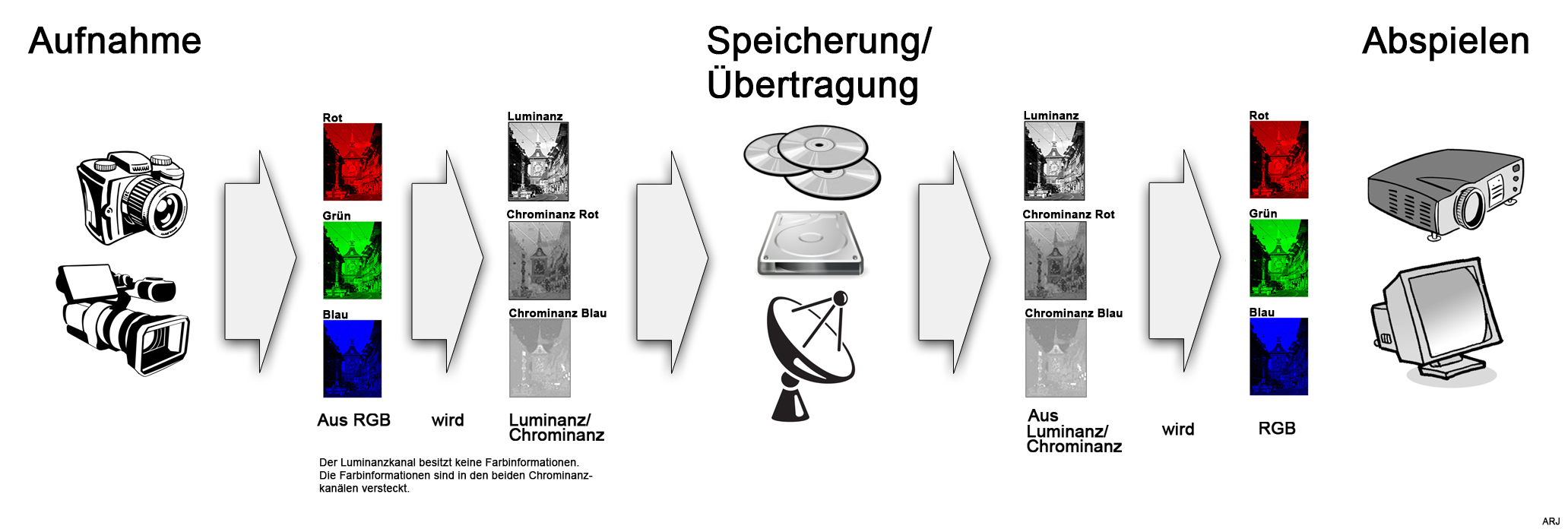

1.3 Das Helligkeits-Farbigkeits-Modell Luminanz/Chrominanz

Das YCbCr-Helligkeits-Farbigkeits-Modell (gemäss CCIR-601 bzw. IEC 601-Standard) wurde

für das Digitalfernsehen entwickelt. Ausserdem wird es für digitale Bild- und Videoaufzeichnung,

bei JPG-Bildern, MPEG-Videos und damit auch bei DVDs,

sowie den meisten anderen digitalen Videoformaten verwendet. Es teilt die Farbinformation in die (Grund-)Helligkeit Y

und die Farbigkeit, bestehend aus den zwei Farbkomponenten Cb (Blue-Yellow Chrominance) und

Cr (Red-Green Chrominance) auf.

Die Helligkeit entspricht der Hellempfindlichkeit des Auges, die im grünen Spektralbereich am grössten ist.

Chrominance oder kurz Chroma bedeutet Buntheit.

Die unterschiedliche Wahrnehmung von Y gegenüber den Cb- und Cr-Kanälen entspricht der

Entwicklung der Farb- und Helligkeitsverteilung in der Natur: Im Laufe der Evolution hat sich der menschliche Sehsinn daran angepasst.

Das Auge kann geringe Helligkeitsunterschiede besser erkennen als kleine Farbtonunterschiede,

und diese wiederum besser als kleine Farbsättigungsunterschiede. So ist ein Text grau auf schwarz geschrieben gut zu lesen,

blau auf rot geschrieben bei gleicher Grundhelligkeit jedoch nur sehr schlecht.

Die Analogie zum menschlichen Sehsinn wird für einen grossen Vorteil von YCbCr genutzt:

die Farbunterabtastung (engl. chroma subsampling).

Dabei wird die Abtastrate und damit die Datenmenge der Chrominanz-Kanäle Cb und Cr gegenüber der

Abtastrate des Luminanz-Kanals Y reduziert, ohne dass es zu einer spürbaren Qualitätsverringerung kommt.

So kann man z. B. mit der JPEG-Komprimierung eine nicht unerhebliche Datenmenge einsparen.

Das YUV-Farbmodell der analogen Fernsehtechnik wird manchmal fälschlicherweise mit YCbCr für

digitale Darstellung von Farbvideosignalen gleichgesetzt. Der Einfachheithalber bedienen wir uns für die folgenden Erklärungen bei dem YCbCr-ähnlichen YUV-Farbmodell. Wer es ganz genau wissen will,

konsultiert die einschlägige Fachliteratur oder informiert sich bei den entsprechenden Beiträgen auf Wikipedia.

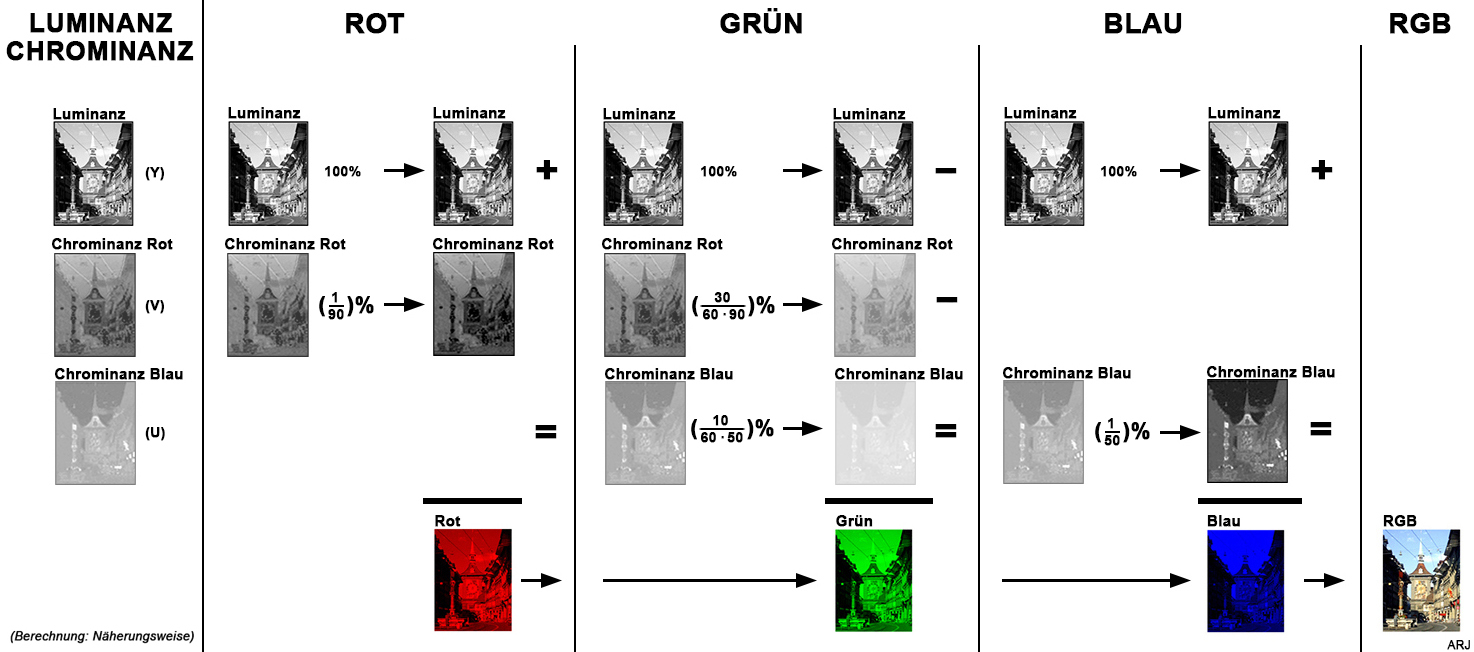

Die RGB zu Luminanz/Chrominanz-Konvertierung (YUV-Farbmodell)

Die Luminanz/Chrominanz zu RGB-Konvertierung (YUV-Farbmodell)

Zusammenfassend

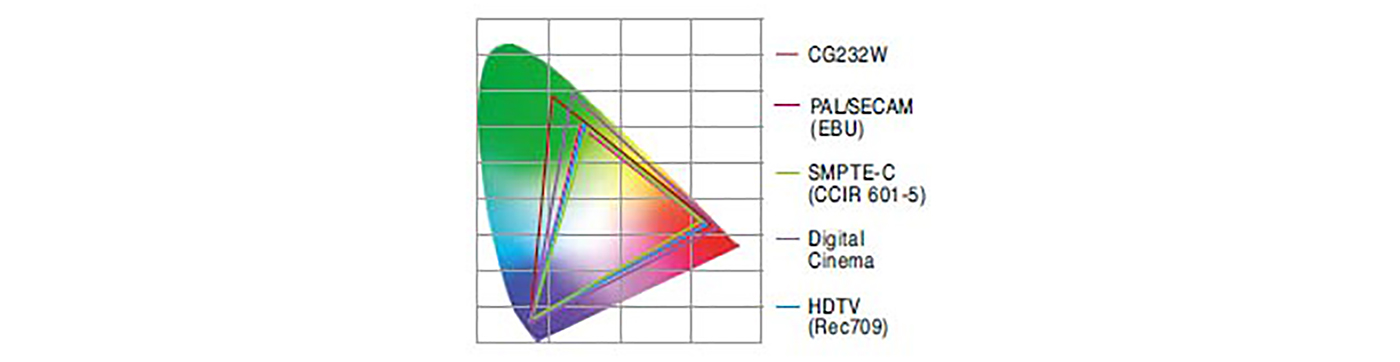

Weitere Farbräume

Full Range RGB in 8 Bit bedeutet 0..255 Helligkeitswerte in allen drei Farbkanälen.

Da aber unser Auge nicht für jede Farbe gleich empfindlich ist, werden die 3 x 8 Bits in gewissen Farbräumen etwas anders aufgeteilt.

Im Television-Bereich kommen auch noch technische Aspekte hinzu, die es nicht zulassen, den ganzen Helligkeitsbereich auszunutzen,

weil dann unter Umständen Übertragungseinrichtungen durch zu hohe Videosignalpegel beschädigt werden können.

So definiert z.B. die ITU-R-Empfehlung REC.709 einen Bereich von 16..235 Helligkeitswerte. Man spricht dann von sendefähigem Material.

AfterEffects bietet ihnen unter Effekte/Farbkorrektur den Effekt "Sendefähige Farben" an.

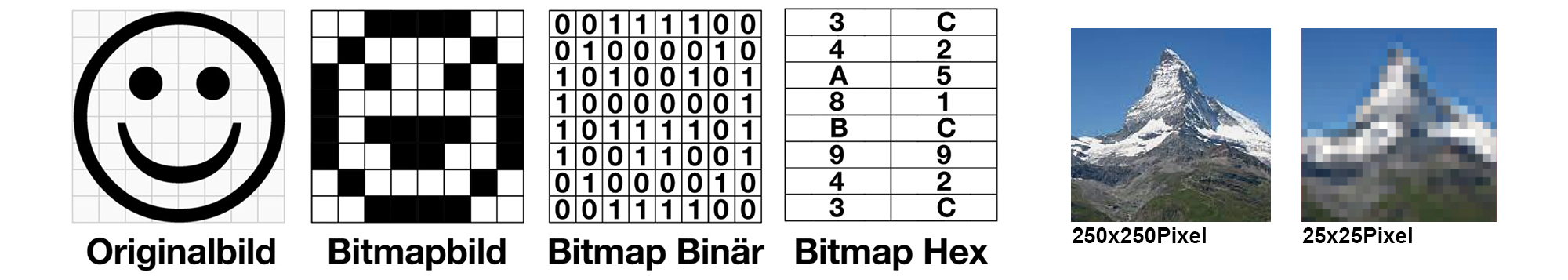

1.4 Vektorgrafik versus Rastergrafik

- Rastergrafik, Bitmap oder Pixelmap: Durch z.B. ein Foto-Objektiv auf einen CCD-Sensor (CCD → Charge Coupled Device) oder CMOS-Sensor (z.B. als APS → Active Pixel Sensor) "eingefangene" Bildpunkte.

(CMOS ist übrigens die Bezeichnung für spezielle und nicht nur lichterfassende Halbleiterbauelemente → Complementary Metal Oxide Semiconductor)

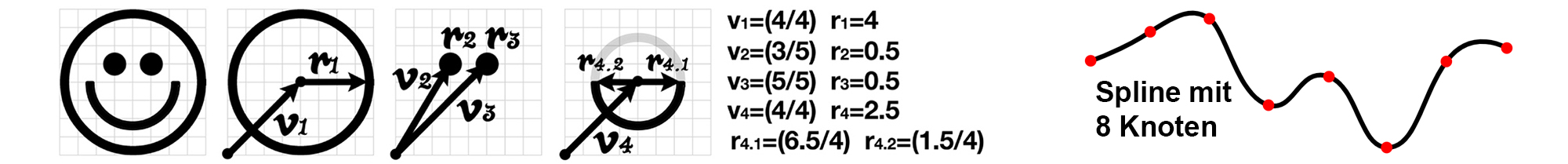

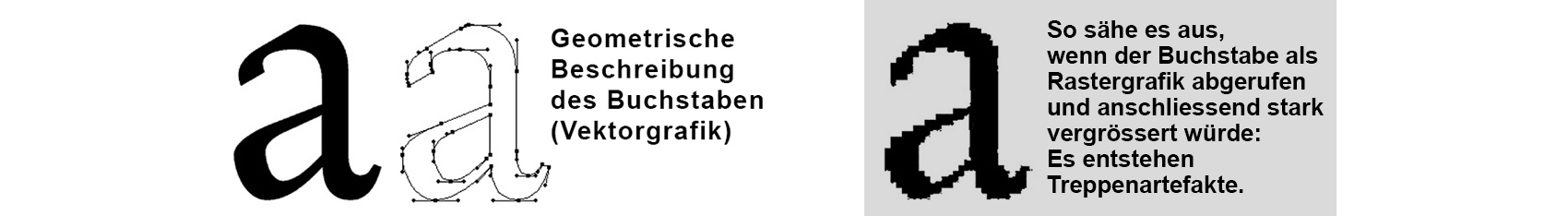

- Vektorgrafik: Eine Vektorgrafik wird aus grafischen Primitiven wie Linien, Kreisen, Polygonen

oder allgemeinen Kurven (Splines) beschrieben. Da die Vektorgrafik verlustlos skalierbar ist, kann sie im Gegensatz zur Rastergrafik ohne entstehende Artefakte beliebig vergrössert werden.

Bei Schrift-Fonts (z.B. TTF → TrueType Font) handelt es sich übrigens um Vektorgrafiken.

Die Vektorgrafik beschreibt ein Bild mathematisch und muss bei jeder Ausgabe auf einen Bildschirm oder einen Matrixdrucker wie Inkjet- oder Laserprinter Pixel für Pixel in eine Rastergrafik

der gewünschten Auflösung (Breite x Höhe) umgerechnet (gerendert) werden.

Anders sieht das beim Ausgabegerät "Stiftplotter" aus, wo ein in einer Ebene aufgehängter und in x-Achse und y-Achse verschiebbarer Zeichenstift die Grafik zu Papier bringt: Dieser "versteht" prinzipbedingt direkt Vektordaten.

Typische Anwendung von Vektorgrafiken → Schriftzeichen (Font)

Typische Anwendung von Vektorgrafiken → Schriftzeichen (Font)

- TTF → TrueType-Fontformat: Dateierweiterung .ttf oder .ttc (ttc → TrueType Collection)

- PostScript-Fontformate: Type-1-Schriften. Dateierweiterungen: .pfm → PostScript-Font-Metric; .pfb → PostScript-Font-Binary; .inf → Allgemeininformationen; .afm → Adobe-Font-Metrics

- OpenType: TrueType-flavoured OpenType → Dateiendung .ttf und PostScript-flavoured OpenType → Dateiendung .otf

- Fontsätzen: ARIAL, COURIER NEW, COMIC SANS MS, FUTURA, FRUTIGER, HELVETICA etc.

(Nicht alle Fontsätze beinhalten den kompletten ASCII- und schon gar nicht den vollständigen UTF8-Zeichensatz. Gewisse Fancy-Schriftsätze beschränken sich auf die Zeichen A-Z, 0-9, inklusive dem Bindestrich - )

1.5 Bildartefakte

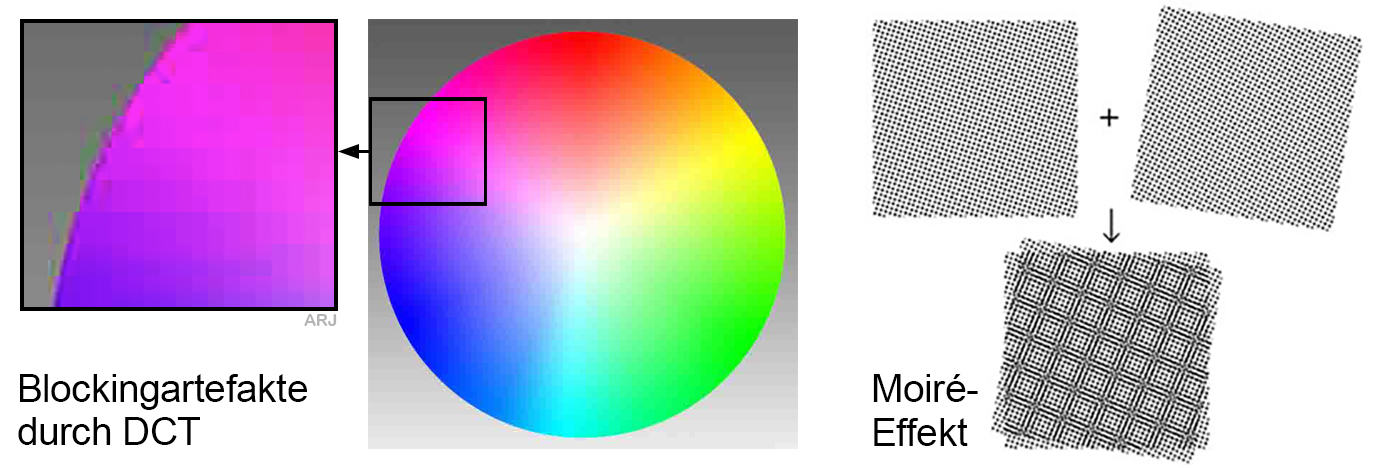

- Der Moiré-Effekt (von frz. moirer, „moirieren; marmorieren“) macht sich bei der Überlagerung von regelmässigen feinen Rastern durch zusätzliche scheinbare grobe Raster bemerkbar. Diese sich ergebenden Muster, deren Aussehen den Mustern aus Interferenzen ähnlich ist, sind ein Spezialfall des Alias-Effektes durch Unterabtastung.

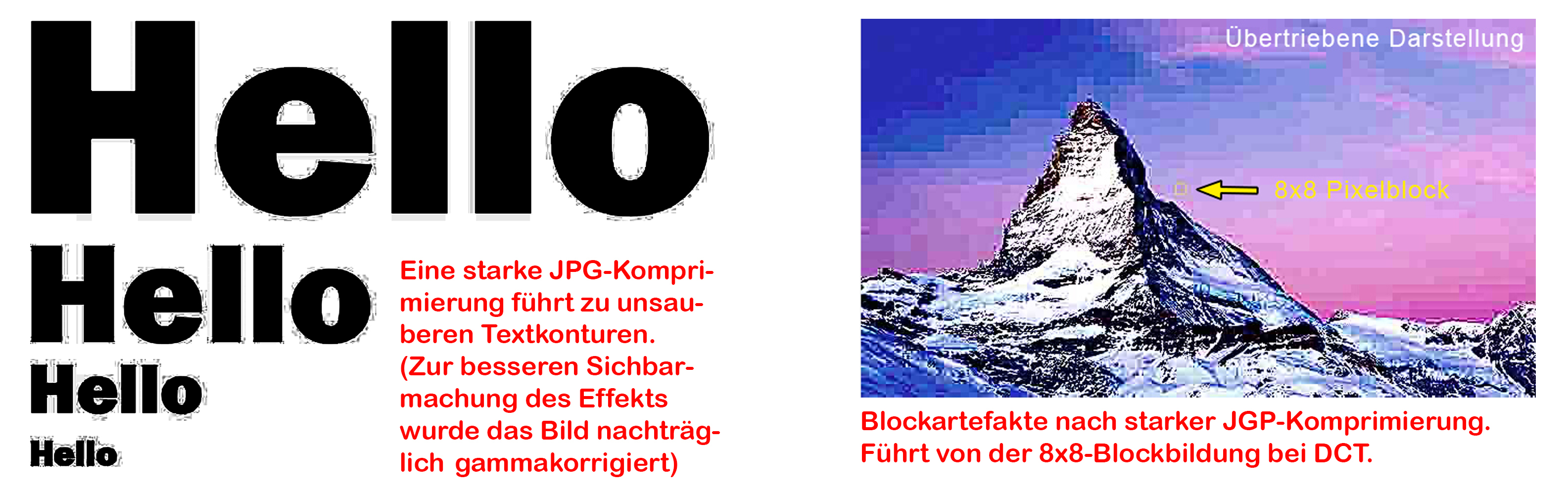

- Die Blockingartefakte entstehen durch allzustarker DCT-Komprimierung bzw. Quantisierung der DCT-Koeffizienten.

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

2. Bildformate

2.1 JPEG, JPG (Joint Photographic Experts Group)

Wird seit Beginn des WWW-Zeitalters von allen Webbrowsern unterstützt!

Auch heute empfiehlt es sich, für Bilder und Fotos dieses Format zu verwenden.

JPEG lässt eine ordentliche Bildkompression zu. Eine zu starke erzeugt allerdings unübersehbare Blockstrukturen,

sogenannte Blocking-Artefakte. Siehe dazu im folgenden Kapitel "Datenkompression" den Beitrag mit der DCT-Demo-App.

Zusammenfassend:

Zusammenfassend:

- JPG ist für Fotos und Bilder geeignet.

- JPG kann jeder Webbrowsertyp und Version seit der ersten WWW-Generation darstellen.

- JPG ist fast beliebig stark verlustbehaftet komprimierbar. (Achtung: Es können Block-Artefakte entstehen)

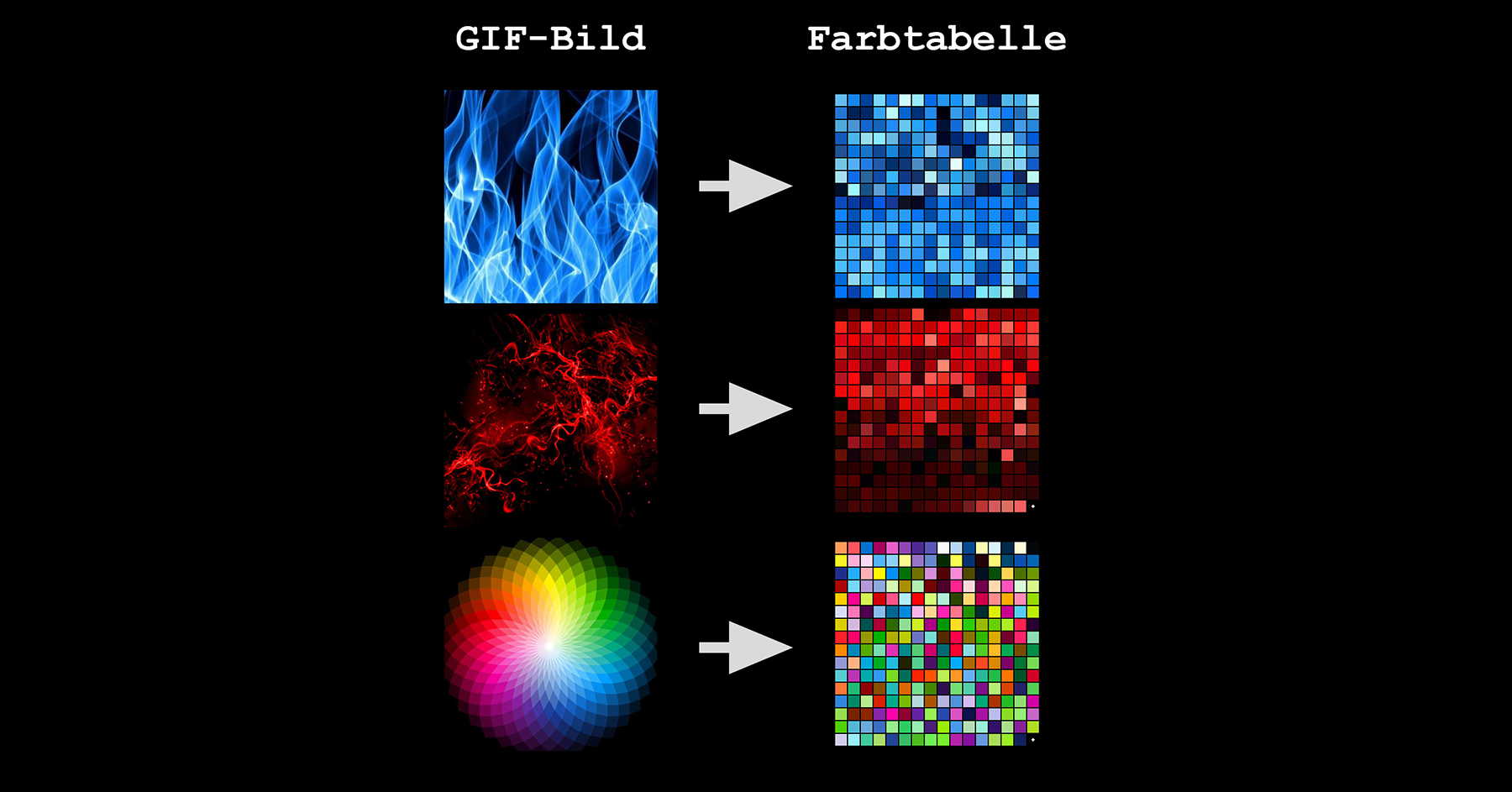

2.2 GIF, Animated GIF (Graphics Interchange Format)

Das GIF ist ebenfalls ein Bildformat, das von den Webbrowsern schon immer

angezeigt werden konnte, ja sogar einmal das Web-Standardbildformat war. GIF eignet sich z.B. für Logos,

wegen der Einschränkung auf die 256 Farben der Farbtabelle aber weniger für Fotografien.

Beim GIF-Format kann eine Transparenzfarbe zur Ausmaskierungen bestimmt werden.

In diesem Bereich ist das PNG Format dem GIF-Format allerdings überlegen, weil dies nicht nur eine Transparenzfarbe,

sondern einen Alphakanal zur Maskierung anbietet. GIF hat auch in der heutigen Zeit noch seine Daseinsberechtigung. Dies

wegen der bisher von Konkurrenzprodukten erfolglos angefochtenen Möglichkeit, Animationen zu erstellen.

Zusammenfassend:

Zusammenfassend:

- Das GIF-Format verwendet man vorzugsweise für Grafiken und Logos.

- GIF-Bilder können von jedem Webbrowsertyp und Version seit der ersten WWW-Generation dargestellt werden.

- GIF kann eine bestimmte Farbe als Transparenzmaske verwenden.

- Animated-GIF sind kleine Animationen oder Fimsequenzen in der Form von aneinandergereihten Bilder, die in einer vordefinierten Geschwindigkeit und Wiederholrate im Webbrowser abgespielt werden können. Z.B. der von Webseiten bekannte schaufelnde Bauarbeiter bei «Under construction».

- Die Umwandlung eines JPG-Bild in das GIF-Format ergibt Artefakte (Farbsäume) infolge der Farbreduzierung gegenüber dem Originalbild.

2.3 PNG (Portable Network Graphics)

PNG ist ein Grafikformat für Rastergrafiken mit verlustfreier

Datenkompression. PNG wurde als freier Ersatz für das ältere, bis zum Jahr 2006 mit Patentforderungen belastete

Graphics Interchange Format GIF entworfen. PNG unterstützt neben unterschiedlichen Farbtiefen auch Transparenz per Alphakanal.

2.4 SVG (Scalable Vector Graphics)

SVG ist ein Format zur Beschreibung zweidimensionaler Vektorgrafiken.

SVG, das auf XML basiert, wurde erstmals im September 2001 veröffentlicht. Praktisch alle relevanten Webbrowser

können einen Grossteil des Sprachumfangs darstellen. Animationen werden von SVG mittels SMIL unterstützt.

Manipulationen des SVG-DOM sind mit Hilfe eingebetteter Funktionen via Skriptsprachen möglich.

2.5 BMP (Windows Bitmap)

BMP ist ein zweidimensionales Rastergrafikformat, welches 1990 eingeführt wurde.

Es unterstützt verschiedene Farbtiefen aber keinen Transparenzkanal. Seit neuerer Zeit wir das BMP Format von den Webbrowsern

ebenfalls angezeigt. Da Windows-Bitmaps entweder unkomprimiert oder verlustfrei mit RLE-Komprimierung gespeichert werden,

sind BMP-Dateien wesentlich grösser als andere Formate wie PNG und daher für das Internet wenig interessant.

2.6 TIF (Tagged Image File Format)

TIFF oder kurz TIF ist neben PDF und EPS ein wichtiges Format zum Austausch

von Daten in der Druckvorstufe in Verlagen und Druckereien, weil es das von ihnen verwendete CMYK-Farbmodell unterstützt.

Ausserdem kann man TIFF-Bilder mit hoher Farbtiefe von bis zu 32 Bit pro Farbkomponente speichern,

weshalb TIFF gern zum Datenaustausch bei der RAW-Konvertierung verwendet wird.

Im Internet wird TIFF genutzt, um Anwendern, wie etwa Verlagen, hochaufgelöste Bilder in druckfähiger,

verlustfreier Qualität zur Verfügung zu stellen. Dabei wird in Kauf genommen,

dass diese Dateien ein Mehrfaches der Grösse eines verlustbehaftet komprimierten JPEG-Bildes haben.

TIFF hat sich so als Quasi-Standard für Bilder mit hoher Qualität etabliert.

Webbrowser des Jahrgangs 2018 und früher konnten TIF-Bilder noch nicht anzeigen.

Und wie es heute ausschaut, können sie gleich selber sehen:

2.7 PSD (Photoshop-Bilddatei)

PSD war bisher und wird vermutlich auch in Zukunft kein Web-Grafikformat! Das Photoshop Document (PSD) ist ein proprietäres Bildformat,

das in Adobes Bildbearbeitungsprogramm Photoshop zur Anwendung kommt.

Das Format enthält unter anderem Alphakanal, Bildebenen etc. und es werden verschiedene Farbräume unterstützt.

Falls Sie anschliessend nur einen leeren grauen Balken sehen, bedeutet dies, dass dieser Webbrowser das Format PSD nicht darstellen kann.

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

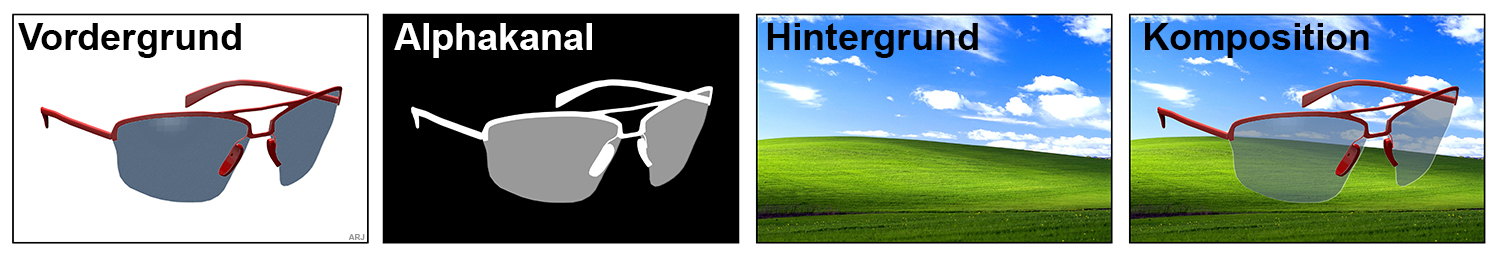

3. Transparenzmasken und Alphakanal

Vom Matte-Painting zum Alphakanal: Matte Paintings (von engl. "matte" = Maske = Vorsatzmalerei) sind gemalte Teile von Kulissen in Filmsets, die auf Leinwand oder Glas aufgebracht wurden. Heutzutage werden fast alle Matte Paintings digital erstellt. Dazu braucht es im Bild neben den drei Farbkanälen RGB noch einen weiteren Kanal, den Alphakanal. Dieser speichert die Transparenz (Durchsichtigkeit) der einzelnen Pixel (Bildpunkte).

Durch die Informationen im Alphakanal des Vordergrundbildes werden die Pixel in den einzelnen RGB-Kanälen transparent oder deckend gesetzt.

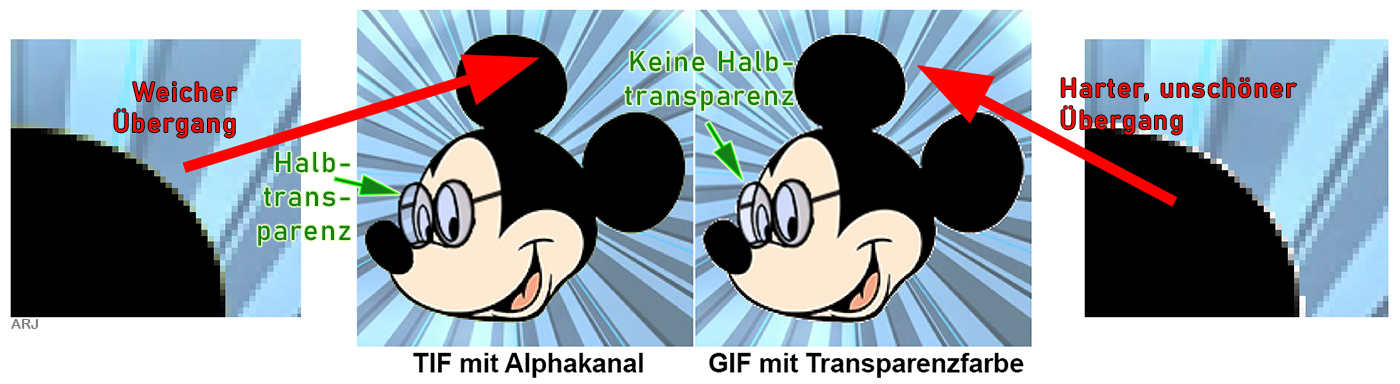

TIFF, TGA, PNG, PSD-Formate unterstützten einen direkten Alphakanal, das JPG-Format dagegen nicht.

Spezialfall GIF: Eine Farbe (aus max. 256 Farben/8Bit) kann als Transparenz definiert werden. Der Nachteil dabei:

Scharfer Maskenrand und daher Treppeneffekt beim maskierten Gegenstand. Keine Halbtransparenzen möglich.

Masken und Transparenz bei Adobe After Effects

«After Effects» ist eine typische Multimedia-Software und bietet eine präzise Kontrolle bei der kreativen Gestaltung von animierten Grafiken und visuellen Effekten in den Bereichen Film, Video, Multimedia und Internet und kann als «Photoshop» für die 4. Dimension (Zeit) betrachtet werden. «After Effects» wird hauptsächlich in der Filmpostproduktion eingesetzt. «Premiere» ist ein ähnliches Produkt von Adobe, deckt aber mit dem Videoschnitt einen etwas anderen Aufgabenbereich ab. Als weiteres Werkzeug wird die vom selben Hersteller die Bildbearbeitungs-Software «Photoshop» angeboten. Weitere Tools von anderen Herstellern für die Filmpostproduktion sind z.B.: Combustion, Flame, Inferno, Toxik, Eyeon Fusion, Apple Motion, The Foundry Nuke und BlackmagicDesign Fuse. Alternativen zu AfterEffects sind rar, insbesondere wenn sie kostenlos sein müssen. Folgende unentgeltlichen Applikationen können Teilgebiete von AfterEffects abdecken: FusionFree von BlackmagicDesign und Blender.

In AfterEffects sind folgende Maskierungsarten möglich:

- Bild mit direktem Alphakanal:

Bild enthält 4 Kanäle nämlich Rot/Grün/Blau/Alpha (RGBA) - Bild mit integriertem Alphakanal (Premultiplied):

Zusätzlich zu RGBA wird die Alphainformation noch in die Farbkanäle eingerechnet. Vollkommen transparente Bereiche werden mit einer Farbe - meist Schwarz oder Weis - vollfarbig dargestellt. Enthält das Bild z.B. noch halbtransparente Bereiche, wird die Farbe prozentual in die jeweiligen Pixel eingerechnet. Bsp.: Bei halber Deckkraft 50% der Farbe des Pixels. - Bild ohne eigenen Alphakanal bzw. separatem Alphakanal

Eigene Datei mit den Transparenzinformationen - Masken / Traveling Mattes

Durch einen Pfad erstellte Ausmaskierung eines Bildes (Ebenenmaske). Form und Lage der Maske kann von Bild zu Bild geändert werden - Keyer

Durch das Programm erstellte Maske, sog. Keyingeffekte (Ebenentransparenz wird durch eine bestimmte Farbe definiert wie zB. bei einer Greenscreen-Aufnahme)

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

4. Videoformate

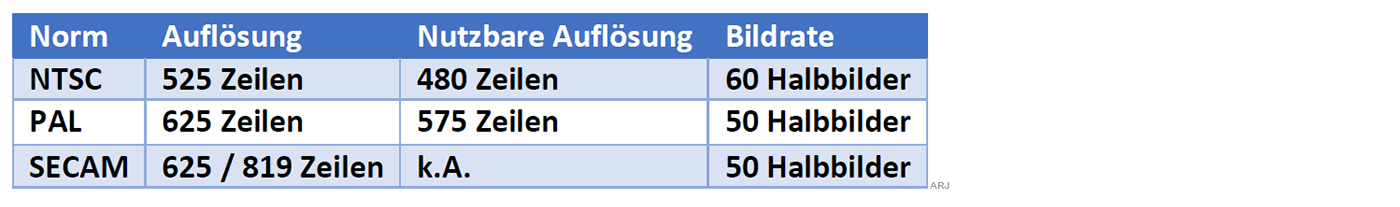

4.1 Historische Fernsehnormen in Standard-Definition

Analog (PAL, NTSC, SECAM)

- SD Standard Definition

- NTSC National Televisions System Committee

Einführung: SW ca. 1942, Color ca.1953

Verbreitung: Nord-Südamerika Ostasien

Bemerkungen: Bei Funk/Kabelverbreitung mögliche Farbtonveränderungen (Never the same Color) - PAL Phase Alternating Line

Einführung: SW ca. 1963, Color ca.1967

Verbreitung: Europa, Australien, Teile Asiens & Afrikas

Bemerkungen: Spätere Norm und daher aus NTSC-Fehlern gelernt - SECAM Séquentiel couleur à mémoire

Einführung: 1956

Verbreitung: Frankreich, Ehemalige Ostblockstaaten, Russland, Teile Asiens & Afrikas

Bemerkungen: Entwickelt aus marktprotektionistischen und politischen Gründen

Digital (PAL, NTSC)

PAR = Pixel Aspect Ratio

4.2 Aktuelle Fernsehnormen in High-Definition

Digital HD (HDTV)

FCC (Federal Communications Commission / US-Organisation)

ATSC (Advanced Television System Committee / US-Organisation, löst NTSC in den USA ab)

EBU (European Broadcasting Union)

fps: Frames per second (Bilder pro Sekunde) Im Falle von Interlaced handelt es sich eigentlich um Halbbilder

AR: Aspect Ratio (Bild Seitenverhältnis)

4.3 Next generation HD (UHD)

(Ultra High Definition Television UHDTV oder Ultra HDTV und Ultra High Definition Video UHDV)

4.4 Video-Normen und Datenraten

Begriffserklärungen:

DV=Digital Video → Legacy consumer videotape recording

DVCAM/DVCpro → Professionelle Variante von DV

HDV=High Definition Video → Video-Bandaufzeichnung

AVCHD=Advanced Video Codec High Definition → Consumer/Prosumer-Bereich

HDCAM=High Definition CAM → Schnittstelle: SDI= Serial Digital Interface,

für den Profibereich, HDTV-Produktionen, Film

XDCAM → HD-Profi-Format von SONY für den Broadcast-Bereich

4.5 Übertragungsraten gängiger Schnittstellen

Angaben in Bit pro Sekunde, Bruttodatenrate! Stand 2020

- Mobilfunk:

♦ GPRS: 115kb/s

♦ UMTS: 384 kb/s

♦ LTE: 1.2 Gb/s

♦ 5G: zukünftig bis zu 10Gb/s - Optische Speichermedien:

♦ Audio-CD: 1.4Mb/s (Speicherkapazität CD: 650MB .. 900MB)

♦ Video-DVD: 10Mb/s (Speicherkapazität: 4.7GB pro Layer. Max. 2 Layer pro Seite)

♦ BluRay: 432Mb/s (Speicherkapazität: 25GB pro Layer. Max. 2 Layer pro Seite) - USB (Universal Serial Bus):

♦ USB-2: 480Mb/s

♦ USB-3: 4Gb/s

♦ USB-3.1: 10Gb/s

♦ USB-3.2/USB-C: 20Gb/s

♦ USB-4: 40Gb/s - FireWire bzw. i.LINK oder IEEE 1394:

♦ Firewire-800: 800Mb/s - SCSI/SAS (Small Computer System Interface, Serial Attached SCSI):

♦ SCSI-320 (Parallel): 2.6Gb/s

♦ SAS-3 (Seriell): 12Gb/s

♦ SAS-4 (Seriell): 22.5Gb/s

♦ SAS-5 (Seriell): ca. 45Gb/s - SATA (Serial Advanced Technology Attachment):

♦ S-ATA R2: 3.0Gb/s

♦ S-ATA R3: 6.0Gb/s - Apple-Thunderbolt:

♦ Thunderbolt 2: 20Gb/s

♦ Thunderbolt 3: 20Gb/s

♦ Thunderbolt 4: 40Gb/s - HDMI (High Definition Multimedia Interface):

♦ HDMI 1.3: 8.2Gb/s

♦ HDMI 2.1: 42.7Gb/s - Display-Port:

♦ V1.4: 25.92Gb/s

♦ V2.0: 77.37Gb/s

4.6 Codecs und Containerformate

- CODEC: Das Kofferwort "CoDec" bestehend aus Coder und Decoder

bezeichnet ein Verfahren, das Daten oder Signale digital kodiert und dekodiert.

Meist werden beim Kodiervorgang die analogen Signale nicht verlustlos digitalisiert, sondern es wird eine

Dynamikreduktion des analogen Signals sowie eine

Datenkompression des digitalen Signals vorgenommen,

die je nach Ausmass und Verfahren zu Qualitätsverlusten bei der Rückwandlung des digitalen Datenstroms

in die analogen Signale führt. Bild und Ton können betroffen sein aber auch die Kontinuität der Wiedergabe.

Beispiele zu Video-Codecs:

♦ Cinepak ♦ Sorenson ♦ Sorenson3 ♦ DV-PAL ♦ DV-NTSC ♦ MPEG-1 ♦ MPEG-2 ♦ MPEG-4 ♦ MPEG-4 Implementierungen DivX, Xvid und AVCHD ♦ H.261 ♦ H.263 ♦ H.264 ♦ H.265 ♦ Flashvideo FLV und F4V ♦ Theora ♦ RealVideo ♦ 3rd Generation Partnership Project für Smartphone 3GPP ♦ Windows Media Video wmv

Beispiele zu Audio-Codecs:

♦ MPEG1 Layer 2 ♦ MPEG1 Layer3 → MP3 ♦ Ogg Vorbis ♦ RealAudio ♦ Windows Media Audio wma - CONTAINER: Container sind Behälter, der unterschiedliche Dateitypen enthalten kann.

Mit dem Format wird die Art und Weise beschrieben, wie die Datenformate innerhalb des Containers angeordnet sind (innere Struktur).

Audio/Videocontainerformate können zumindest einen Audio- und einen Videostream enthalten.

Einige Formate ermöglichen zusätzlich die Einbettung von Untertiteln und Menüstrukturen oder anderen Inhalten.

Beispiele zu Audio/Video-Containers:

Microsoft AVI → Audio-Video Interleave ♦ ADOBE Flash Video ♦ Apple Quicktime mov ♦ Blu-ray Disc ♦ DVD ♦ MPEG-2 Stream ♦ RealMedia

Medienbeispiele

- Video-DVD-Container:

Video-Codec: MPEG2

Mögliche Audio-Codecs: MPEG-1 Layer2 oder PCM - BluRay-Container:

Mögliche Video-Codecs: H.264/MPEG4 oder AVC oder VC-1 oder MPEG2

Mögliche Audio-Codecs: Dolby-Digital, DTS (Digital Theater System High Definition), PCM (Pulse Code Modulation)

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

5. Datenkompression

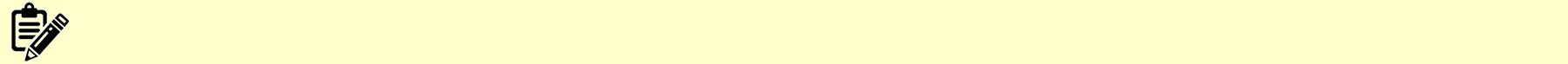

Wenn Daten wie z.B. Texte, ausführbare Programme etc. komprimiert werden sollen,

darf das anschliessende Expandieren nicht zu Verlusten führen.

Es muss somit ein verlustloses Verfahren gewählt werden.

Einige dieser Konzepte wie die Huffman-Kodierung, RLC/RLE - Run Length Coding/Encoding und weitere werden an einer anderen Stelle dieser Webseite genauer behandelt.

Im Medienbereich (Bild und Ton), wo riesige Datenmengen anfallen, ist das Bedürfnis effizient zu komprimieren besonders hoch.

Allerdings genügen die sogenannten verlustlosen Verfahren alleine nicht.

Die Medieninhalte müssen vor der eigentlichen Komprimierung speziell aufbereitet werden.

Etwa so, wie beim Burrows-Wheeler-Verfahren, wo ein Text durch die Umstellung der Buchstaben

in eine für das Run-Length-Coding günstige Anordnung transformiert wird.

Diese vorangehende "Medienaufbereitung" hat allerdings den Nachteil,

dass sie meist zu Datenverlusten führt: Das heisst:

Nach der Komprimierung kann durch das Expandieren nicht mehr das 100% Abbild des Originals erstellt werden.

Die Datenverluste unterscheiden sich je nach Komprimierungsverfahren und Komprimierungsintensität.

Moderne Verfahren sind aber so clever, dass für den Betrachter kaum Einbussen erkennbar sind (Bsp. MPEG-4, AAC etc.).

Im weiteren spielt im Medienbereich auch die Qualität der weitere Verarbeitungskette/Projektion eine Rolle

(Bsp. Audio(analog)verstärker, Lautsprecher, Farbtreue des Projektors etc.)

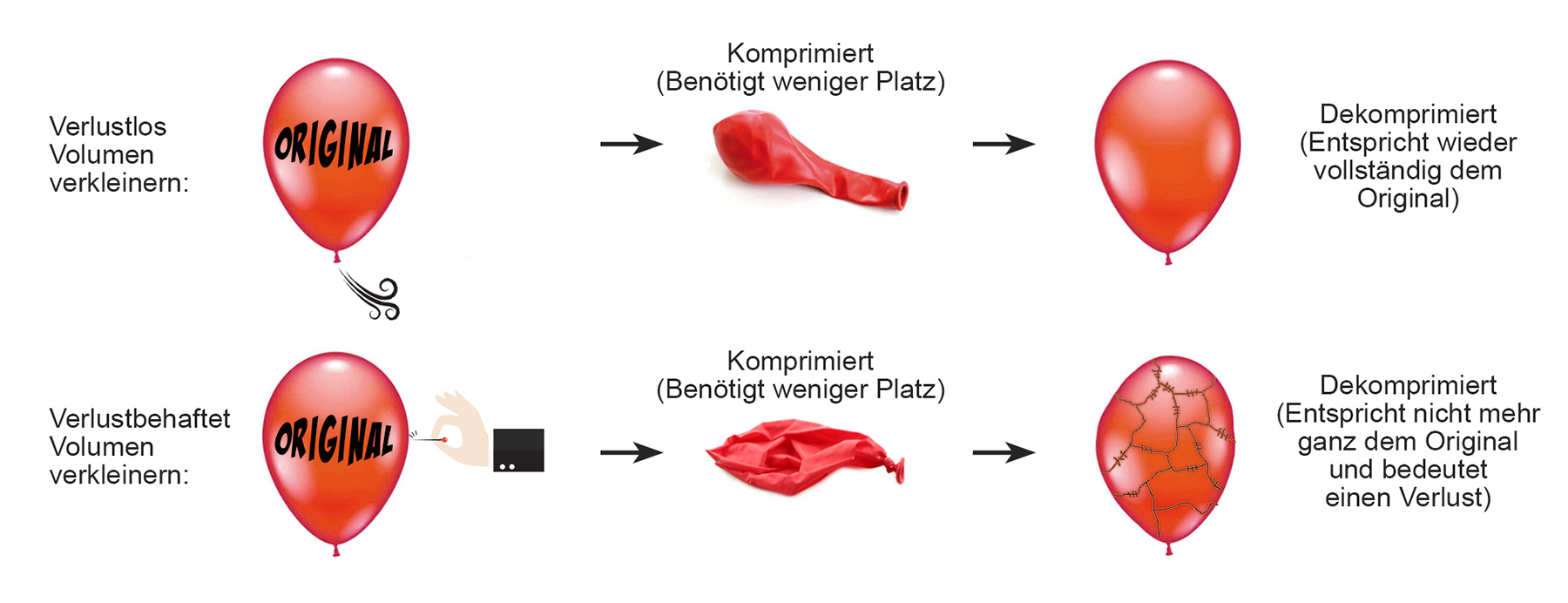

Bei der verlustbehafteten Komprimierung muss man immer einen Kompromiss eingehen, zwischen:

- ...der Stärke der Komprimierung und damit der Einsparung von Bits und Bytes bei der Datenübertragung und Datenspeicherung...

- ...und die durch die Kompression hervorgerufenen Artefakte, Bildunschärfe, verminderte Bildqualität, Bildflackern etc.

(Nicht ganz so wie es vorher war, aber so ähnlich: In Spanien hat eine Amateur-Restauratorin versucht, ein Jesus-Fresko aufzufrischen und die alte

Kirchenmalerei bis zur Unkenntlichkeit überpinselt.)

(Nicht ganz so wie es vorher war, aber so ähnlich: In Spanien hat eine Amateur-Restauratorin versucht, ein Jesus-Fresko aufzufrischen und die alte

Kirchenmalerei bis zur Unkenntlichkeit überpinselt.)5.1 Bildauflösung und Farbtiefe reduzieren

Die einfachsten Komprimierungsverfahren sind die Reduktion der Bildgrösse oder der Farbigkeit:

- Bild 1 → Originalbild:

1000 Pixel x 540 Pixel, 16.7 Millionen Farben (24Bit) - Bild 2 → Reduzierte Bildauflösung:

100 Pixel x 54 Pixel, 16.7 Millionen Farben (24Bit)

Dateigrösse 100x kleiner als das Original

(Hinweis: Das deutlich unscharfe Bild zeigt die Dekomprimierung auf die Ausgangsgrösse von 1000x540!) - Bild 3 → Reduzierte Farbauflösung:

1000 Pixel x 540 Pixel, 16 Farben (4Bit)

Dateigrösse 6x kleiner als das Original - Bild 4 → Graustufenbild: 1000 Pixel x 540 Pixel, 256 Graustufen (8Bit)

Dateigrösse 3x kleiner als das Original

- Bild 5 → JPG mit tiefer Qualität (Hohe DCT Komprimierung):

1000 Pixel x 540 Pixel, 16.7 Millionen Farben, Bildartefakte/Blockbildung!

Dateigrösse 42.8x kleiner als das Original - Bild 6 → JPG mit hoher Qualität (Tiefe DCT Komprimierung):

1000 Pixel x 540 Pixel, 16.7 Millionen Farben

Dateigrösse 4.8x kleiner als das Original.

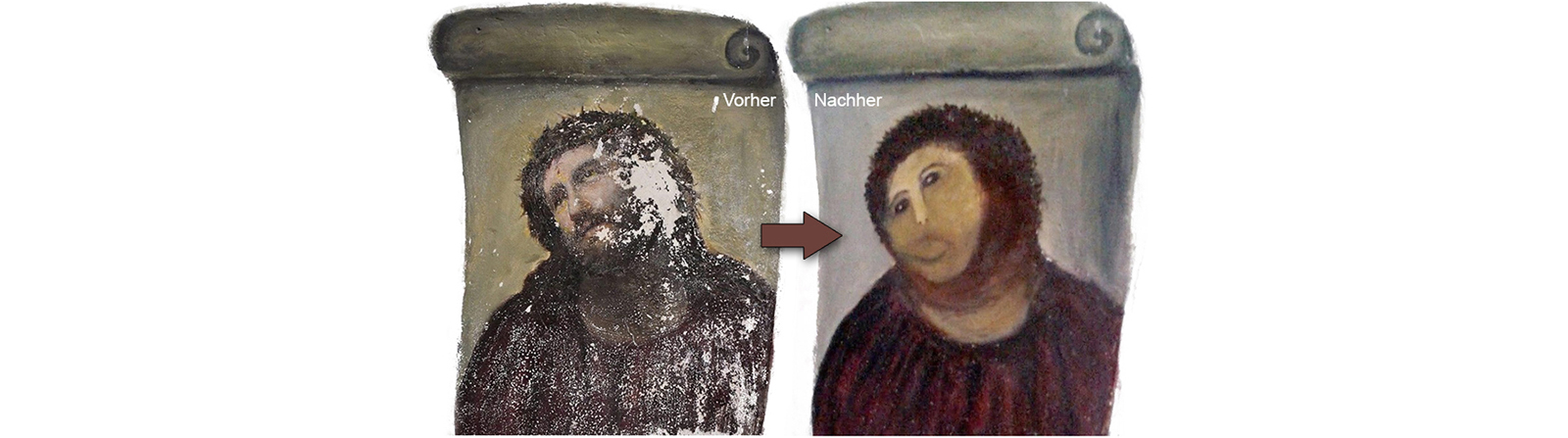

5.2 Die Farbunterabtastung/Subsampling

Farbunterabtastung (Color Subsampling) bezeichnet bei der Bildaufnahme ein Verfahren,

das der Reduzierung der benötigten Datenmenge dient (Reduktion von Speicherplatz bzw. Übertragungsbandbreite).

Voraussetzung ist die Verwendung eines geeigneten Farbmodells, das Chrominanz (Farbinformation) und Luminanz (Helligkeitsinformation) getrennt beschreiben kann.

Das Das YCbCr-FarbModell, dass die Farbinformation in die Grundhelligkeit Y und die zwei Farbkomponenten Cb

(Blue-Yellow Chrominance) und Cr (Red-Green Chrominance) aufteilt, scheint da geeignet.

Die Chrominanz wird mit einer gegenüber der Luminanz reduzierten Abtastrate gespeichert. Der subjektive optische Qualitätsverlust ist gering,

da das menschliche Auge Farbe mit geringerer Auflösung wahrnimmt als Helligkeit. Farbunterabtastungen findet man z.B. in der Videotechnik und bei JPEG.

Ohne Unterabtastung trägt jeder Kanal mit je 100% zum Gesamtvolumen (300%) bei. Mit einer Unterabtastung von 4:1:1 bedeutet dies ein Y-Anteil=100%, Cr-Anteil=25%, Cb-Anteil=25% und somit ein Gesamtvolumen von 150%. Der Speicherbedatf hat sich nun halbiert bzw. von 300% auf 150% gesenkt.

Ohne Unterabtastung trägt jeder Kanal mit je 100% zum Gesamtvolumen (300%) bei. Mit einer Unterabtastung von 4:1:1 bedeutet dies ein Y-Anteil=100%, Cr-Anteil=25%, Cb-Anteil=25% und somit ein Gesamtvolumen von 150%. Der Speicherbedatf hat sich nun halbiert bzw. von 300% auf 150% gesenkt.

- Subsampling 4:4:4 Keine Unterabtastung / Keine Reduktion in

Farbkanälen / Studiobereich - Subsampling 4:2:2 Unterabtastung in beiden Farbkanälen / 2:1-

Abtastverhältnis; Norm ITU-R BT.601 / Professionelle

Videokameras - Subsampling 4:1:1 Unterabtastung in beiden Farbkanälen / Die

Chrominanz-Bandbreite und damit die horizontale

Farbauflösung ist gegenüber dem 601-Signal halbiert / Digitale

Consumer Kameras in TV-NTSC - Subsampling 4:2:0 Unterabtastung in beiden Farbkanälen,

alternierend / Reduktion der Farbauflösung in der Vertikalen,

da Farbdifferenzsignale zeilenweise abwechselnd und nicht in

jeder Zeile gleichzeitig Übertragen werden / Digitale

Consumer Kameras in TV-PAL

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

5.3 JPG-Bildkomprimierung mit DCT (Discrete Cosine Transformation)

Die diskrete Kosinustransformation DCT (Discrete Cosine Transformation) ist eine Transformation der numerischen Mathematik. Sie wird unter anderem für die verlustbehaftete Kompression von Audio- und Bilddaten verwendet. (JPG-Bildformat, AAC-Audioformat)

(Ein kompletter DCT-Vorgangsbeschrieb kann hier heruntergeladen werden:

DCTDemo.pdf)

(Ein kompletter DCT-Vorgangsbeschrieb kann hier heruntergeladen werden:

DCTDemo.pdf)

Die eigentliche Datenreduktion wird durch ein RLC und VLC bewirkt. DCT ist eigentlich nur dafür da, die Pixelwerte auf eine effektive Datenreduktion vorzubereiten:

- 1. Schritt: Als vorbereitenden Schritt wird das RGB-Bild in seinen Luminanzanteil und den beiden Crominanzanteile umgewandelt. Danach wird die Auflösung in den beiden Chrominanzkanälen reduziert. (Siehe Farbmodelle und Unterabtastung)

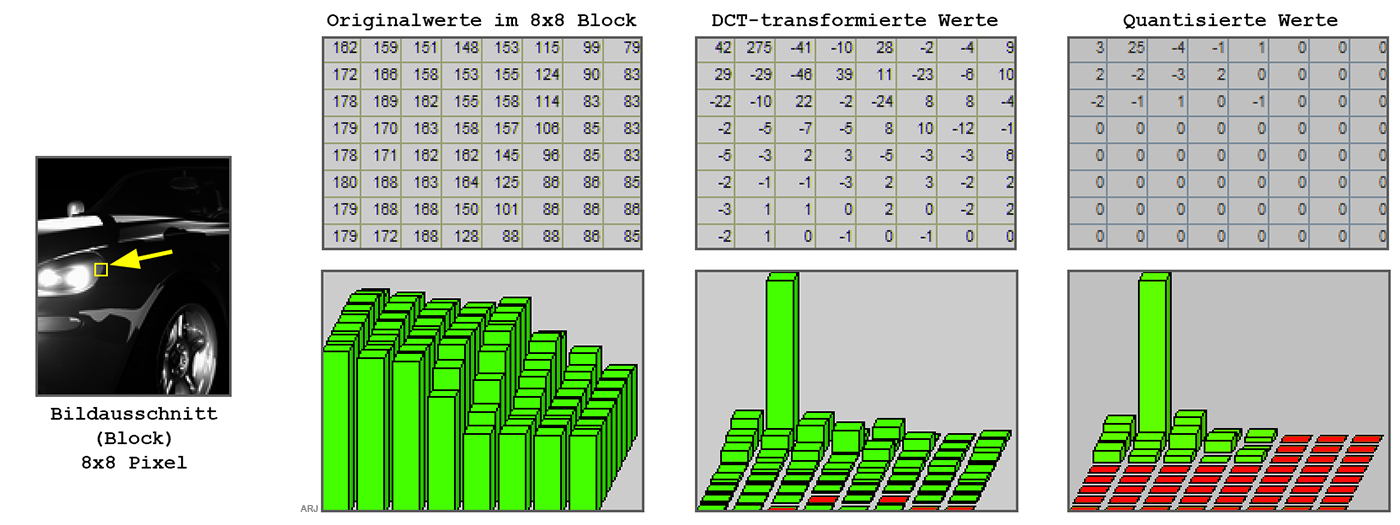

- 2. Schritt: Das Bild (Luminanz- bzw. Chrominanzkanäle) wird nun in 8x8 Pixelblöcke aufgeteilt. Jeder dieser Pixelblöcke wird separat weiterverarbeitet. (Siehe Bild: Originalwerte im 8x8 Block - Die Zahlen entsprechen den Helligkeitswerten des Pixelblocks)

- 3. Schritt: Diskrete Kosinus Transformation (Siehe Bild: DCT-transformierte Werte). Die 8x8 Wertematrix wird nun vom Bildbereich in den sogenannten Frequenzbereich transformiert. Im Bildbereich prägen Unterschiede in den Helligkeitswerten die Wertematrix, wohingegen im Frequenzbereich die Schnelligkeit der Helligkeitsänderungen entscheidend sind. (Etwas vereinfacht ausgedrückt: Scharfe Bilder ergeben schnelle Helligkeitsänderungen und damit viele hohe und unterschiedliche DCT-Werte, unscharfe langsamere und somit tiefere und weniger unterschiedliche DCT-Werte.)

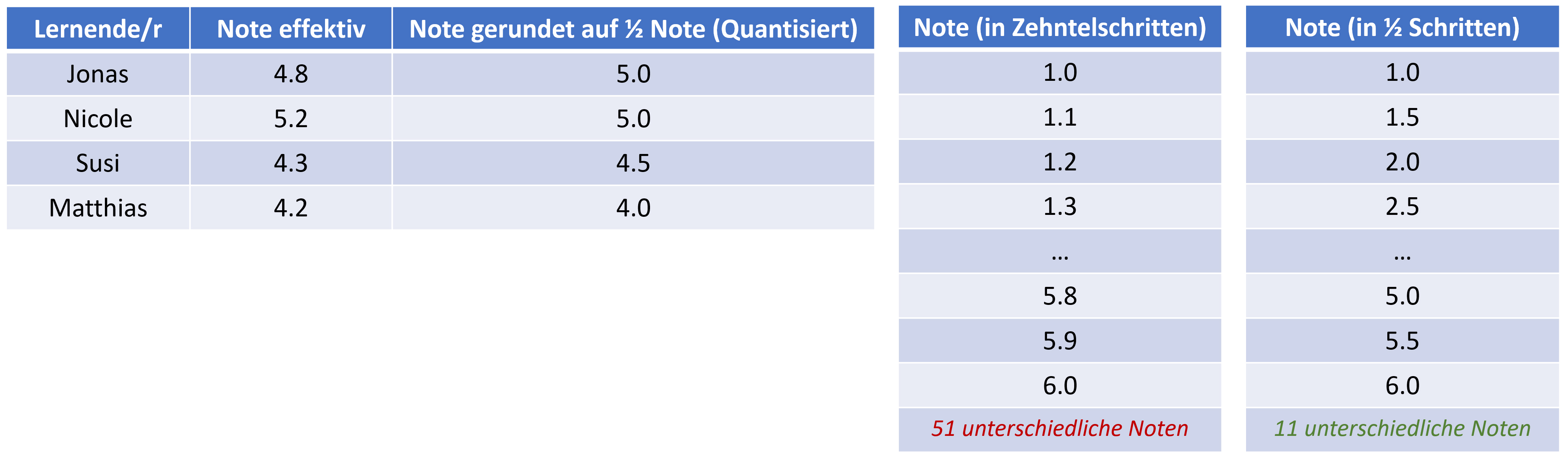

- 4. Schritt: Die DCT-transformierten Werte werden nun quantisiert. Unter Quantisierung ist etwa dasselbe zu verstehen, wie das Notenrunden bei Schulprüfungen: Wenn die Schulnote mit einer Genauigkeit von 1/10 festgehalten wird, hat man mehr mögliche Notenwerte als wenn die Note auf 0.5 gerundet wird. Allerdings verliert man mit der gröberen, weil ungenaueren 0.5-er Notenskala auch an Aussagekraft. Dasselbe gilt für die quantisierten DCT-Werte (Siehe Bild: Quantisierte Werte). Bis jetzt hat man allerdings noch keine eigentliche Datenreduktion erreicht.

- Wie geht's weiter: Abhängig von der Stärke der Quantisierung der DCT-Werte (im Extremfall werden die meisten Werte 0) erhält die 8x8-Matrix eine geeignete Form, für eine anschliesend effiziente RL-Codierung (RLC) und zusaätzlich VL-Codierung (VLC). (RLC und VLC werden übrigens in den Fachartikeln zu Informationstechnik unter Verlustlose Kompression erklärt.)

Noch eine Bemerkung zur diskrete Kosinus Transformation: Im Extremfall, wenn ein 8x8-Pixelblock nur aus einer einzigen Farbe besteht, wird nach der DC-Transformation nur die erste DCT-Koeffiziente links oben einen Wert enthalten und alle anderen 255 Werte werden 0 sein. RLC ist dann besonders wirksam. Im Umkehrschluss: Wenn die Quantisierung sehr stark ausfällt, wird ein 8x8 Pixelblock bei der Rücktransformation nur noch wenige, gleichartige Farbwerte aufweisen. Man nent das Blocking-Effekt.

Die Quantisierung bei DCT erklärt am Beispiel von Schulnoten

- 51 unterschiedliche Noten bedeutet 6 Bit pro Note

- 11 unterschiedliche Noten bedeutet 4 Bit pro Note

Mit nur 11 unterschiedlichen Noten erreicht man eine Speicherersparnis von 33% gegenüber der Variante mit 51 unterschiedlichen Noten. Allerdings ergibt sich auch ein Informationsverlust. Aus den gerundeten Noten ist nicht mehr ersichtlich, dass Nicole fast eine halbe Note höher liegt als Jonas. Ähnlich bei Susi, die zwar nur 1/10 höher liegt, gerundet aber eine um eine halbe Note höhere Bewertung erhält.

DCT-Zusammenfassung:

- DCT ist nur eine Vorbereitung der Pixelwerte (ählich bei BWT und LZW), um anschliessend mit RLC effizient die Datenmenge zu reduzieren.

- DCT lässt bei hohem Komprimierungsgrad Textkonturen ausfransen.

- Wenn bei DCT die Qualität zu stark reduziert wird, ergeben sich sogenante Block-Artefakte, das heisst 8x8 Pixelblöcke gleicher Farbe.

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

5.4 Interframe Komprimierung

Darunter versteht man die Datenreduktion innerhalb einer Bildfolge unter Ausnutzung von Ähnlichkeiten in nacheinander folgenden Bildern (Differenzbilder). Wenig Bewegung bedeutet eine hohe Datenreduktion. Dies ist eigentlich eine verlustlose Komprimierung. Meist wird aber bei einer Interframekomprimierung noch zusätzlich eine verlustbehaftete Komprimierung durchgeführt. Im Vergleich dazu spricht man bei DCT von einer Intraframe-Komprimierung (Komprimierung innerhalb eines Bildes).

5.5 Die GOP-Sequenz

GOP bedeutet Group of Pictures. Damit ist eine Bildgruppe gemeint, die mit einem Schlüsselbild (I-Frame oder Vollbild) beginnt. Danach folgen eine gewissen Anzahl B-Frames und P-Frames, bis wieder eine neue Bildgruppe mit startendem I-Frame folgt.

- I-Frame: Schlüsselbild, Keyframe, Vollbild: Mit Intraframe-Komprimierung wie z.B. JPG.

- B-Frame: Bidirektional Differenz-codiertes Einzelbild (Bidirectionally Predictive-Coded): Einzelbild (Frame), das über die Differenz zu vorhergehenden und nachfolgenden Einzelbildern beschrieben wird.

- P-Frame: Differenzkodiertes Einzelbild (Predictive-Coded Picture): Einzelbild (Frame), das über die Differenz zu vorhergehenden Einzelbildern beschrieben wird (Delta-Kodierung)

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN

6. Audio

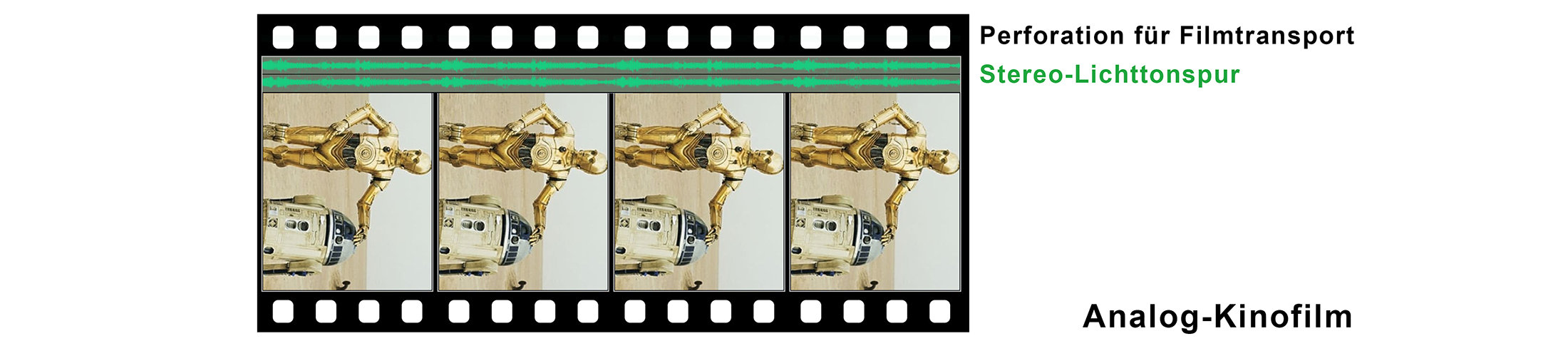

6.1 Analog-Audio

Die Schallplatte ist ein wichtiger Vertreter der damaligen analogen Audiotechnik. Die durch eine Nadel abgetastete Rille zeigt den analogen Verlauf des

akustischen Signals.

Das Lichttonverfahren ist das älteste und noch heute gebräuchliche Tonfilm-Verfahren, bei dem Bild- und Toninformation auf demselben Träger

aufgebracht sind. Der Ton wird auf einem Streifen (Tonspur) fotografisch gespeichert. Da die Bilder schrittweise weiterbefördert werden

während ein analoges Tonsignal vom konstant laufenden Filmstreifen abgetastet werden muss, werden hier Bild und Ton zeitlich versetzt auf

dem Träger gespeichert.

Das Lichttonverfahren ist das älteste und noch heute gebräuchliche Tonfilm-Verfahren, bei dem Bild- und Toninformation auf demselben Träger

aufgebracht sind. Der Ton wird auf einem Streifen (Tonspur) fotografisch gespeichert. Da die Bilder schrittweise weiterbefördert werden

während ein analoges Tonsignal vom konstant laufenden Filmstreifen abgetastet werden muss, werden hier Bild und Ton zeitlich versetzt auf

dem Träger gespeichert.

6.2 Digital-Audio

Für die Aufnahme von Ton benötigt man ein Mikrofon. Dabei handelt es sich um einen analogen Sensor. Die Ausgabe des Tons erfolgt über einen Lautsprecher. Dies ist ein analoger Aktor. Da der Mikroprozessor im PC nur 0 und 1 versteht, also rein digital arbeitet, müssen

Da der Mikroprozessor im PC nur 0 und 1 versteht, also rein digital arbeitet, müssen

- Signale von analogen Sensoren wie Mikrofone zuerst digitalisiert werden

- Signale an analoge Aktoren wie Lautsprecher von Digital auf Analog gewandelt werden.

Soll eine analoge Grösse wie z.B. ein von einer Mikrofonkapsel gelieferter Spannungswert in einem Rechner verarbeitet, gespeichert etc. werden, muss der Spannungswert zuerst in seine digitale Form umgewandelt werden. Dazu dient ein Analog-Digital-Wandler. Für die Rückwandlung von Digital zu Analog verwendet man einen Digital-Analog-Wandler. (Auf den Digital-Analog-Wandler wird hier nicht weiter eingegangen.)

6.3 Die Analog-Digital-Wandlung

Ein digitale Signal kann aus einem Analogsignal, welches den zeitlich kontinuierlichen Verlauf einer physikalischen Grösse beschreibt, durch die Quantisierung und eine Abtastung/Sampling, welche zu definierten Zeitpunkten erfolgt, gebildet werden. Die digitalen Werte sind üblicherweise als Binärzahlen/Dualcode kodiert, so dass ihre Quantisierung in Bits angegeben wird. Analog-Digitalwandlung eines Audiosignals:

Die Digitalisierung eines analogen Signals hat immer zur Folge, dass das originale analoge Signal nicht mehr verlustlos rekonstruiert werden kann.

Je nach Abtastrate und Auflösung kann man aber das digitale Signal in ein qualitativ befriedigendes analoges Signal zurückverwandeln.

Der von der Digitalisierung herführende Treppeneffekt bzw. die dadurch entstehenden Oberwellen beim zurückverwandelten

Analogsignal können mit entsprechenden analogen Filtern (Tiefpassfilter) unterdrückt bzw. herausgefiltert werden.

Beispiel MusicCD:

Bei der MusicCD wird das analoge Signal mit einer Samplingrate von 44.1kHz bei einer Auflösung von 16 Bit (65'536 verschiedene Analogwerte) abgetastet.

Das Abtasttheorem

Das Abtasttheorem besagt, dass ein Signal exakt rekonstruiert werden kann, wenn es mit mindestens der doppelten oberen Grenzfrequenz des analogen Signals abgetastet wurde. Bei der MusicCD mit Audio im hörbaren Bereich von 20Hz bis 20kHz bedeutet dies eine Abtastfrequenz von mindestens 40kHz.

Audio: Ein Frequency-Sweep und Qualitätsvergleiche

Das menschliche Gehör ist in der Lage, Frequenzen zwischen 20 Hertz (20Hz) und 20 Kilohertz (20kHz) zu hören. Die Hörleistung nimmt allerdings im Alter beträchtlich ab.

∇ AUFGABEN

∇ AUFGABEN

∇ LÖSUNGEN